”梯度下降法“ 的搜索结果

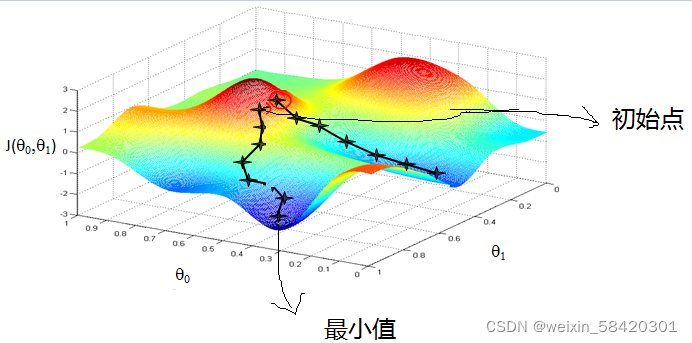

这是一个matlab对梯度下降的实现,模拟的是x^2+y^2最小值的取得

全梯度下降算法(FGD)、随机梯度下降算法(SGD)、随机平均梯度下降算法(SAGD)、小批量梯度下降算法(Mini-batch gradient descent,MGD)梯度下降优化算法,动量法、Adagrad、Adadelta、RMSProp、Adam

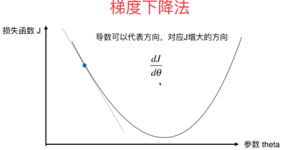

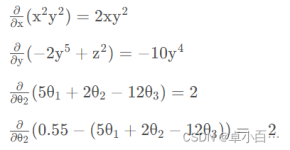

这里就对梯度下降法做一个完整的总结。 1. 梯度 在微积分里面,对多元函数的参数求∂偏导数,把求得的各个参数的偏导数以向量的形式写出来,就是梯度。比如函数f(x,y), 分别对x,y求偏导数,求得的梯度向量就是(∂f...

损失使用平方函数,简单的线性模型 y = theta1 + theta2 * x

目录1.概述2.梯度下降法2.1场景假设 1.概述 2.梯度下降法 2.1场景假设

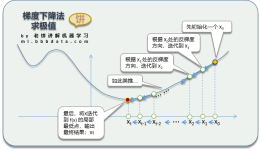

梯度下降法,又称最速下降法,是一个一阶最优化算法,迭代法的一种,可以用于求解最小二乘问题(线性和非线性都可以) 基本思想 可用下山举例说明,将小人看作J(ω),即表示目标函数,目的地是最低点。而中间如何...

基于jupyter notebook的python编程—–利用梯度下降算法求解多元线性回归方程,并与最小二乘法求解进行精度对比目录一、梯度下降算法的基本原理1、梯度下降算法的基本原理二、题目、表格数据、以及python环境搭建1、...

梯度下降算法是一种通用的优化算法,适用于不同的损失函数。可以自动学习优化参数,不需要手动调整参数。梯度下降算法是一种迭代算法,每次更新都会改进模型的性能,直到收敛。梯度下降算法的收敛速度较慢,需要大量...

资源名:训练RBF网络_梯度下降法_matlab 资源类型:matlab项目全套源码 源码说明: 全部项目源码都是经过测试校正后百分百成功运行的,如果您下载后不能运行可联系我进行指导或者更换。 适合人群:新手及有一定经验...

资源中包含随机梯度下降逻辑回归算法的Python代码和测试数据,python的版本为3.6,您运行代码前,将测试文件路径修改为您本地的存储路径,使用pycharm平台运行即可。

梯度下降(Gradient Descent)算法是机器学习中使用非常广泛的优化算法。当前流行的机器学习库或者深度学习库都会包括梯度下降算法的不同变种实现。 本文主要以线性回归算法损失函数求...而梯度下降法就是很好的一个选

梯度下降算法代码及详细解释,使用matlab编程

在这儿,我们再作个形象的类比,如果把这个走法类比为力,那么完整的三要素就是步长(走多少)、方向、出发点,这样形象的比喻,让我们对梯度问题的解决豁然开朗,出发点很重要,是初始化时重点要考虑的,而方向、...

在学习线性回归的时候很多课程都会讲到用梯度下降法求解参数,对于梯度下降算法怎么求出这个解讲的较少,自己实现一遍算法比较有助于理解算法,也能注意到比较细节的东西。具体的数学推导可以参照这一篇博客...

理论模拟仿真了基于变形镜与随机并行梯度下降(SPGD)算法的无波前探测自适应光学系统(AOS)。为提高基于SPGD算法的无波前探测AOS的收敛速度,在不降低精度的前提下,对SPGD算法中关键参数随机扰动幅值和增益系数的关系...

推荐文章

- Adaboost模型公式的参数推导_adaboost加权公式-程序员宅基地

- 削峰填谷与应用间解耦:分布式消息中间件在分布式环境下并发流量控制的应用_消息中间件削峰填谷-程序员宅基地

- C 语言实现智能指针___attribute__((cleanup(free_stack)))-程序员宅基地

- 刮刮卡兑换-程序员宅基地

- H5横屏,移动端缓存_h5 横向-程序员宅基地

- python wx包_今天玩点啥:python真香系列之利用wxpy包写一个微信消息自动回复插件...-程序员宅基地

- 【PCL】使用自定义点类型时LNK2001、LNK2019链接错误解决_使用pcl出现link2019-程序员宅基地

- 获取数组中元素个数的方法_qt获取数组的元素个数-程序员宅基地

- Centos7 安装 docker及docker-compose_yum install -y yum-utils device-mapper-persistent--程序员宅基地

- c 与易语言程序间通信,易语言与三菱PLC通信-FX系列-程序员宅基地