”从头消费partition消息“ 的搜索结果

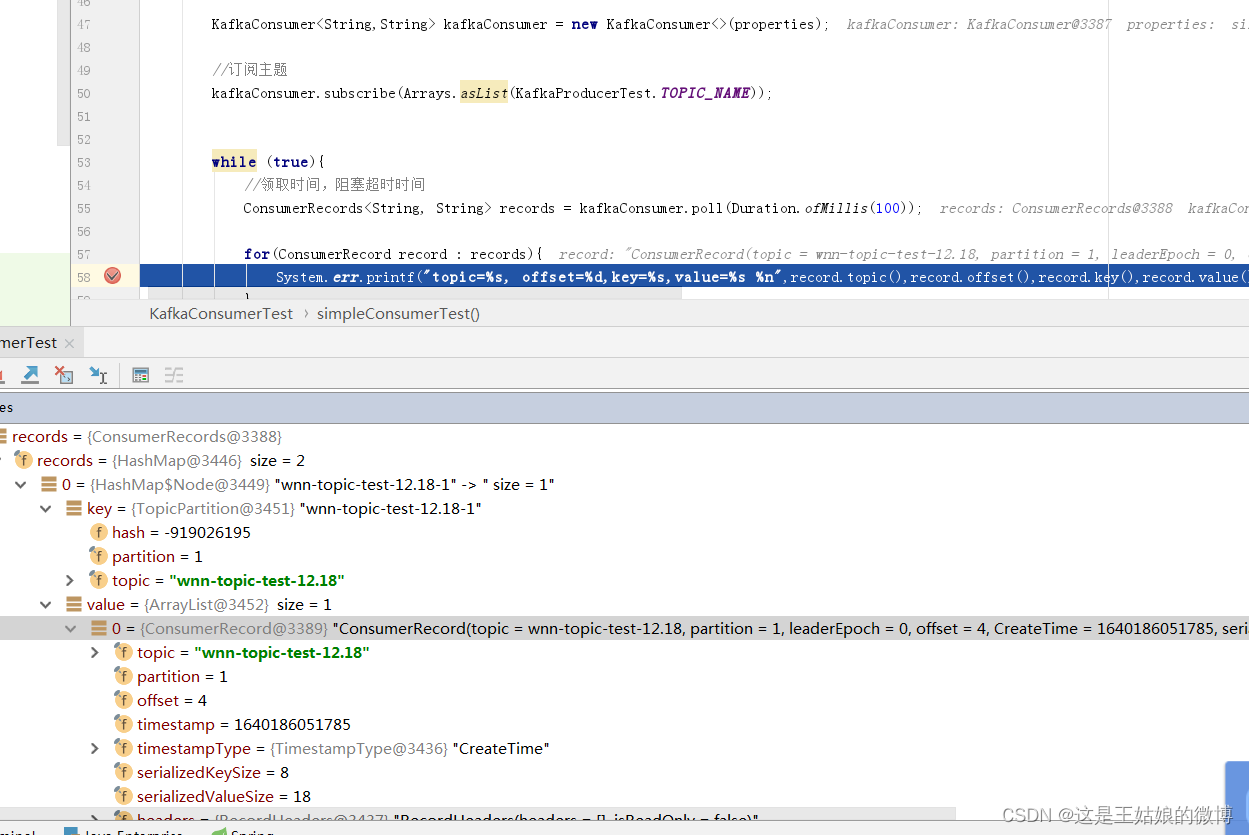

一. Kafka消费者Consumer消费消息配置实战 配置: public static Properties getProperties() { Properties props = ... //消费者分组ID,分组内的消费者只能消费该消息一次,不同分组内的消费者可以重复消费该消息

命令行 1 group id换成新的 2 offset参数设为earliest kafka-console-consumer.sh \ --bootstrap-server mypc01:9092,mypc02:9092,...seekToBeginning方法可以让从头开始消费 //从头开始消费 def ConsumerTest3(): Un

producer发送消息的分区策略 1.默认策略 ...2.自定义分区策略,需实现Partitioner接口的partition方法 producer参数配置 bootstrap-servers:broker地址,ip:port # 消息重发的次数 retries: 1 # 提...

如果需要从头消费partition消息,怎操作? 自动提交offset问题手工提交offset配置和测试初次启动消费者会请求broker获取当前消费的offset值手工提交offset

消费者要从头开始消费某个topic的全量数据,需要满足2个条件(spring-kafka): (1)使用一个全新的"group.id"(就是之前没有被任何消费者使用过); (2)指定"auto.offset.reset"参数的值为earliest; ...

Kafka系列之消息重新消费

标签: kafka

Kafka消息重新消费;通过kafka-consumer-groups.sh脚本修改offset;通过新增group

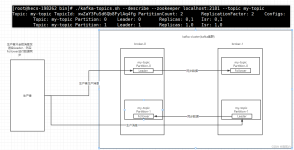

消息者新消费组的消费offset规则 消费者代码基本实现 public class myConsumer { private final static String TOPIC_NAME = "myTopic"; private final static String CONSUMER_GROUP_NAME = "testGroup";

本文主要使用java来实战kafka消费数据的过程,解析并实现kafka手动提交offset和自动提交offset的demo,并进行详细的总结和对比。

key.serializer必须设置为实现org.apache.kafka.common.serialization.Serializer的接口类,Kafka的...在发送消息时,实现kafkaClient的Callback方法,可以以异步的方式接收到RecordMetadata,从而获得消息的各种属性。

正常情况下,消费者在消费消息时候,消费完毕后,会发送一个确认信息给消息队列,消息队列就知道该消息被消费了,就会将该消息从消息队列中删除。只是不同的消息队列发送的确认信息形式不同,例如RabbitMQ是发送一个...

简单实现生产及消费,包括生产消费的配置说明、消费着offset自定义seek等

造成重复消费原因其实都是类似的,确认信息没有传送到消息队列,导致消息队列不知道自己已经消费过该消息了,再次将该消息分发给其他的消费者。 rabbitMQ是消费完成发送一个ACK确认消息, rocketMQ是消费完成返回一个...

从5个小时之前开始消费。 public class SeekConsumer { public static String adminUrl = "http://broker1:8080"; public static String serviceUrl = "pulsar://broker2:6650"; public static void main(String...

今天出现了这样一个问题, A说他的kafka消息发送了;B说它没有接收到;好,带着上面的问题,我们来一步步排查一下问题所在。

当试图在2个奴隶和1个主盒子上设置kafka时,得到了一个奇怪的情况,我无法消耗或产生一个主题 .使用 Mirror Maker 在 slave Master 之间同步数据 . 获取以下日志无休止:[2016-08-26 14:28:33,897] WARN Bootstrap...

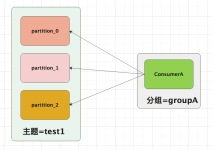

与其他一些消息中间件不同的是:在Kafka的 消费理念 中还有一层 消费组(Consumer Group)的概念,每个消费者都有一个对应的消费组。 当消息发布到主题后,只会 投递给订阅它的每个消费组中的一个消费者。 几个概念...

一、Flink基本了解 Apache Flink其核心是用Java和Scala编写的分布式流数据流引擎。Flink以数据并行和流水线方式执行任意流数据程序,Flink的流水线运行时系统可以执行批处理和流处理程序。 二、环境说明 ...

在 Kafka 中,每当消费者组内的消费者查找不到所记录的消费位移或发生位移越界时,就会根据消费者客户端参数 auto.offset.reset 的配置来决定从何处开始进行消费,这个参数的默认值为 “latest” 。 auto.offset....

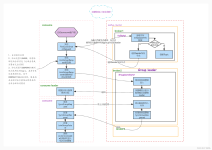

要弄明白这个问题首先你要知道Flink消费kafka数据的时候,Flink的并行度和topic的partition是什么关系?那我们就来简单的看一下源码,FlinkKafkaConsumer的源码比较多,就不从头开始看了,直接看相关部分的代码...

自动提交会丢消息: 因为如果消费者还没消费完poll下来的消息就自动提交了偏移量,那么此 时消费者挂了,于是下一个消费者会从已提交的offset的下一个位置开始消费消息。之前未被消费的消息就丢失掉了。 手动提交...

kafka重新消费的两种方式 低级API AUTO_OFFSET_RESET_CONFIG 方式一:低级API public class MylowerConsumer { public static void main(String[] args) { //1.brokers节点 ArrayList<String> ...

推荐文章

- 【vue-treeselect+vxe-table】数据量大的时候懒加载,数据回显,输入框绑值,末级节点不要前面的箭头等问题详解_treeselect显示加载中-程序员宅基地

- 【从0入门JVM】-01Java代码怎么运行的_代码如何在jvm中运行-程序员宅基地

- TreeViewer应用实例(ITreeContentProvider与LabelProvider的使用)-程序员宅基地

- 如何将别人Google云端硬盘中的数据进行保存_谷歌网盘怎么保存别人的资源-程序员宅基地

- java中查看数据类型_java查看数据类型-程序员宅基地

- Scrapy-redis分布式+Scrapy-redis实战-程序员宅基地

- web播放H.264/H.265,海康,大华监控摄像头RTSP流方案_海康api hls怎么取265的流-程序员宅基地

- HTML详解连载(7)-程序员宅基地

- PHP使用多线程-程序员宅基地

- 由excel一键生成json的小工具(基于python,仅支持单层嵌套)_excel转json github-程序员宅基地