SparkSql创建临时视图

”sparksql“ 的搜索结果

什么是SparkSQL SparkSQL是Spark用于结构化数据处理的模块 SparkSQL的原理 SparkSQL提供了两个编程抽象,DataFrame和DataSet DataFrame 1)DataFrame是一种类似RDD的分布式数据集,类似于传统数据库中的二维...

Spark-Mongodb是一个库允许用户利用Spark SQL读写数据至MongoDB集合

SparkSQL讲解

标签: SparkSQL

SparkSQL详细讲解,很适合入门的!

开窗函数的引入是为了既显示聚合前的数据,又显示聚合后的数据。即在每一行的最后一列添加聚合函数的结果。开窗用于为定义一个窗口(指运算将要操作的行的集合),它对一组值进行操作,不需要使用Group BY子句对数据...

安装java 安装hadoop 安装saprk 安装mysql 安装hive spark连接hive,连接mysql

Catalyst是与Spark解耦的一个独立库,是一个impl-free的执行计划的生成和优化框架。目前与SparkCore还是耦合的,对此user邮件组里有人对此提出疑问,见mail。以下是Catalyst较早时候的架构图,展示的是代码结构和...

1.如何读取mysql中的数据? public class JDBCDataSource { public static void main(String[] args) { SparkConf conf = new SparkConf().setAppName("JDBCDataSource&... JavaSp...

作业脚本采用Python语言编写,Spark为Python开发者提供了一个API-----PySpark,利用PySpark可以很方便的连接Hive下面是准备要查询的HiveSQLselectsum(o.sale_price),sum(case when cate_id2 in(16,18) then o.sale_...

其实start-thriftserver.sh 执行了spark-submit --class org.apache.spark.sql.hive.thriftserver.HiveThriftServer2 --name Thrift JDBC/ODBC Server)1、由于cdh自带spark版本不支持spark-thrift服务,所以需要在...

文章目录简介源码实现SparkSQL使用示例 简介 Bitmap是用来实现基数统计的一种常用方法,它可以实现精确的基数统计。为了提高bitmap对稀疏位图的压缩率,提出了RoaringBitmap(RBM)对稀疏位图进行压缩,减少了内存...

一:JDK环境搭建其中重要的就是两个安装路径JDK路径和JRE路径,三个环境变量:JAVA_HOME、PATH、CLASSPATH我本地的是 JDK路径(D:\JAVA\JDK\) JRE路径(D:\JAVA\JRE)JAVA_HOME(D:\JAVA\JDK)PATH(%JAVA_HOME%\bin;...

五分钟学大数据-SparkSQL底层执行原理

SparkSQL窗口函数 MySQL参考 表达式: function OVER (PARITION BY … ORDER BY … FRAME_TYPE BETWEEN … AND …) 窗口定义部分和窗口函数部分 (1)窗口定义部分(over后面的小括号中的内容): 如果只写over,所有...

这是Spring Boot开发SparkSQL读取Hive数据库,并可使用Web接口查询Hive数据的基本步骤。4. 创建一个`@Controller`类,并注入`PersonRepository`类,并添加一个Web接口API,用于呈现查询结果。下面是使用Spring Boot...

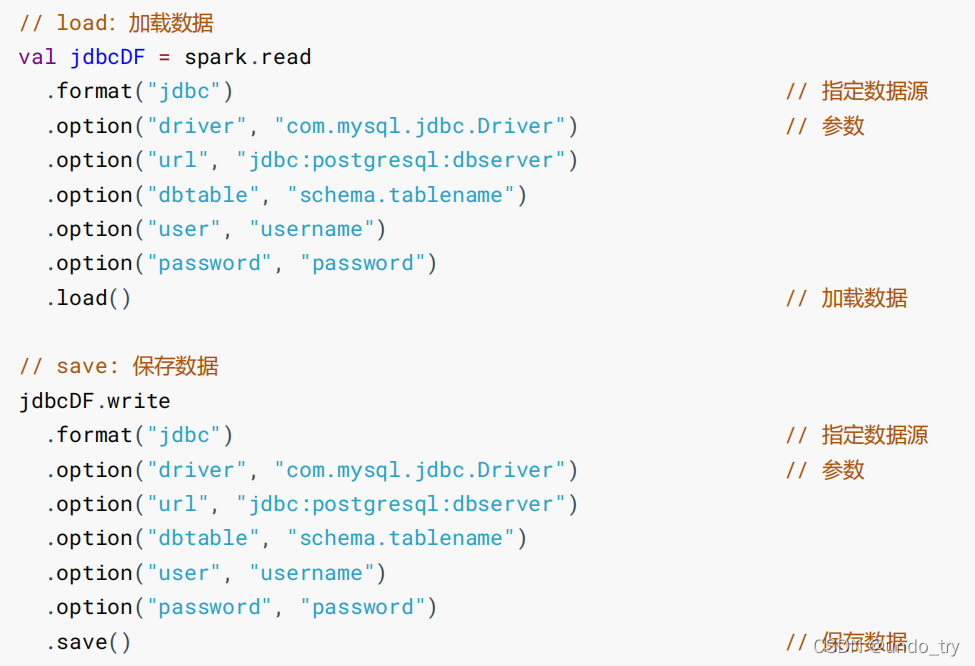

一、什么是SparkSQL 二、SparkSQL特点 三、SparkSQL中两个编程抽象 四、IDEA开发SparkSQL操作Mysql、Hive 1. 添加依赖 2. 读取数据 五、附录 一、什么是SparkSQL SparkSQL是Spark用于结构化数据(structured...

kettle连接sparksql

sparkSql 读写Es

4、SparkSql查出来的数据返回的是一个dataframe数据集。 原始数据 scala> val parquetDF = sqlContext.read.parquet(hdfs://hadoop14:9000/yuhui/parquet/part-r-00004.gz.parquet) df: org.apache.spark.sql....

1. SparkSQL 是什么 目标 对于一件事的理解, 应该分为两个大部分, 第一, 它是什么, 第二, 它解决了什么问题 理解为什么会有SparkSQL 理解SparkSQL所解决的问题, 以及它的使命 1.1. SparkSQL 的出现契机 ...

package com.netcloud.bigdata.sparksql import java.util.Properties import org.apache.spark.sql.{SaveMode, SparkSession} /** * DataFrame的创建 * 从已经存在的RDD生成,从hive表、或者其他数据源(本地...

推荐文章

- PTA 剥洋葱(C语言 + 详细注释 + 代码超简单)_c语言pta怎么使用-程序员宅基地

- docker配置国内镜像源_docker国内镜像源-程序员宅基地

- Unity中怎么播放视频_unity 播放视频-程序员宅基地

- 使用BOOTICE 恢复系统启动项_bootice保存后没用-程序员宅基地

- 文本分类与SVM_svm分类-程序员宅基地

- 力扣——206.反转链表_力扣链表反转-程序员宅基地

- 如何解决深度冲突(Z-fighting),画面闪烁的问题-程序员宅基地

- Android 第三方库--2017年Android开源项目及库汇总_panel.travel-tv.top-程序员宅基地

- adb链接模拟器_adbconnect连接模拟器-程序员宅基地

- Python绘图Matplotlib手册-程序员宅基地