PL的流程 很简单,生产流水线,有一个固定的顺序: 初始化 def init(self) --> 训练 def training_step(self, batch, batch_idx) --> training_step_end(self,batch_parts) --> training_epoch_end(self, ...

”pytorch������loss������“ 的搜索结果

开始吧克隆此仓库并运行代码$ git clone https://github.com/KaiyangZhou/pytorch-center-loss$ cd pytorch-center-loss$ python main.py --eval-freq 1 --gpu 0 --save-dir log/ --plot 您将在终端中看到以下信息...

关于RNN的理论部分我们已经在前面介绍过,所以这里直接上代码 数据是csv格式,只有两列,第一列是标签(但是为中文),第二列是text,文本内容。 当然这里也可以加入停用词我们需要构建和处理文本数据的词汇表。...

完整训练过程

今天小编就为大家分享一篇解决Pytorch训练过程中loss不下降的问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

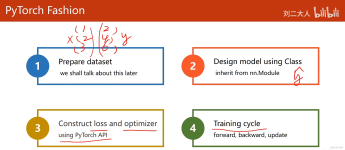

pytorch快速入门深度学习-模型训练和搭建(使用小土堆学习心得)

pytorch深度学习笔记记录1

PyTorch 单机多GPU 训练方法与原理整理这里整理一些PyTorch单机多核训练的方法和简单原理,目的是既能在写代码时知道怎么用,又能从原理上知道大致是怎么回事儿。如果只是炼丹,有时候确实没时间和精力深挖太多实现...

在接触pytorch中CNN的全连接层,卷积层,池化层的创建后,我们便可以使用特定的梯度下降算法,以及特定的损失函数来做简单的线性回归了。 1.离散点的建立 因为是做线性回归,所以我们需要人为臆造一些符合某种线性...

深度学习框架——Pytorch初步:张量Tensor

李沐老师《动手学深度学习(PyTorch版)》3.2线性回归的从零开始实现-笔记&练习详解

Array 13 (2022) 100110Shashank Reddy Vadyala a,*, Sai ...0使用PyTorch解决一维平流方程的物理信息神经网络方法0a 计算分析与建模系,路易斯安那科技大学,美国路斯顿 b 商业与管理系,印度泰拉南加邦梅达克纳

实验结论请看github voc.py ''' @Author : {AishuaiYao} @License : (C) Copyright 2013-2020, {None} @Contact : {[email protected]} @Software: ${segmentation} @File : ${voc}.py @Time : ${2...

一切皆是映射:递归神经网络(RNN)和时间序列数据 1. 背景介绍 1.1 时间序列数据的重要性 在当今的数据驱动世界中,时间序列数据无处不在。从股票价格和天气预报,到语音识别和自然语言处理,时间序列数据都扮演着关键...

LLMs之PPL:解读多个权威文档(比如huggingface)中对PPL(困惑度)的定义、PPL的多种计算方式、代码实现 目录 Chinese-LLaMA-Alpaca-2项目中的PPL代码实现 两种近似算法计算固定...PPL是GPT-St

# note - GLM将针对不同类型下游任务的预训练目标统一为了自回归填空,结合了混合的注意力机制和新的二维位置编码。 - 本文浅析sft,并基于GLM在广告描述数据集上进行sft+p-tuning代码的数据流讲解 自回归空格填充...

金融行业需要垂直领域LLM,因为存在金融安全和数据大多数存储在本地,在风控、精度、实时性有要求 (1)500亿参数的BloombergGPT BloombergGPT金融大模型也是用transformer架构,用decoder路线, 构建目前规模最大的...

Py之peft:peft(一款最先进的参数高效微调方法库)的简介、安装、使用方法之详细攻略 目录 peft的简介 ...参数有效微调(PEFT)方法使预训练语言模型(PLMs)能够有效地适应各种下游应用,而无需微调模型的所有参数...

推荐文章

- centos7初始化mysql 5.7.9(源码安装)-程序员宅基地

- undefined reference to `cvHaarDetectObjects'()(人脸检测)_cvhaardetectobjects未定义-程序员宅基地

- 如何将参数传递给批处理文件?_批处理 传递参数-程序员宅基地

- C++的一些小总结 类 静态成员变量/函数 this指针_c++ class 静态指针函数-程序员宅基地

- springboot小区物业管理系统7ffeo[独有源码]如何选择高质量的计算机毕业设计_小区物业管理系统er图-程序员宅基地

- mac-gradle的安装和配置,掌握这些知识点再也不怕面试通不过_mac gradle配置-程序员宅基地

- 2032:【例4.18】分解质因数(信奥一本通)-程序员宅基地

- html怎么设置默认状态,网页中如何设置默认图片?方式介绍-程序员宅基地

- milp的matlab的案例代码_matlab30个案例分析案例5代码-程序员宅基地

- html实现/ 简约好看、美观大方的个人导航页源码/开源个人主页html源码_个人导航html-程序员宅基地