OnnxruntimeBuilder Onnxruntime构建器

”onnxruntime“ 的搜索结果

解决onnxruntime警告问题

E:onnxruntime:barcode, provider_bridge_ort.cc:995 onnxruntime::ProviderLibrary::Get] LoadLibrary failed with error 126 "找不到指定的模块。" when trying to load onnxruntime_providers_cuda.dll c等错错误

本文主要介绍C++版本的onnxruntime使用,Python的操作较容易就不再提及了。 一、克隆及编译 git clone --recursive https://github.com/Microsoft/onnxruntime cd onnxruntime/ git checkout v1.8.0

这篇文章背景是笔者在ubuntu上编译C++代码,依赖一些包,然后需要编译并配置到CMakelist做的笔记。主要也是一直不太懂CMakellist,做个笔记以防忘记,也...4. 编译onnxruntime;5. CMakelist配置;6. Clion远程调试C++

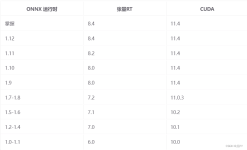

代码中需要修改一下如果运行出现下面这样的报错:那就直接把模型输入输出的名字写进去:2、运行速度我这次用的是yolov5-6.2版本的yolov5n模型,在C++上用onnxtime部署,用视频大概检测其推理速度,发现onnxruntime比...

资源来自pypi官网。 资源全名:onnxruntime-1.0.0-cp35-cp35m-manylinux1_x86_64.whl

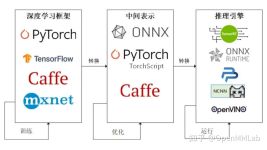

简单来说,对于机器学习模型过程可分为和这一条流水线解决了模型部署中的两大问题:使用对接深度学习框架和推理引擎的中间表示,开发者不必担心如何在新环境中运行各个复杂的框架;通过中间表示的网络结构优化和推理...

python库,解压后可用。 资源全名:onnxruntime-0.4.0-cp36-cp36m-macosx_10_7_x86_64.whl

onnx, onnxruntime, netron

由于CUDA次要版本兼容性,使用CUDA 11.4构建的Onnx运行时应该与任何CUDA 11兼容x版本。

如何将Yolov5模型在C++端部署,本博客主要介绍ONNX Runtime部署方式,首先将1).pt转成onnx格式;2)编译ONNX Runtime工程,这样就能在c++调用v5模型,为工业界部署提供了很大便捷程度

分别使用OpenCV与ONNXRuntime部署yolov5旋转目标检测源码+模型(python源码).zip 代码完整下载可用,确保可以运行。 分别使用OpenCV与ONNXRuntime部署yolov5旋转目标检测源码+模型(python源码).zip 代码完整...

onnxruntime下载

本文可作为的后续。

ppyoloe于c++中使用onnxruntime调用onnx。

ONNX Runtime 部署:超分辨率demo

加载onnx模型报错:错误原因:onnx文件损坏。

使用onnxruntime部署segment-anything模型

这个错误的原因是输入的数据类型和预期的数据类型不匹配。根据错误信息,实际输入的数据类型是 unsigned 8-bit integer (tensor(uint8)),而预期的数据类型是浮点数 (tensor(float))。这意味着模型期望输入浮点数,...

推荐文章

- 魅蓝note5 Flyme6.3.0.2A root教程-程序员宅基地

- java h5实现视频播放_Springboot项目使用html5的video标签完成视频播放功能-程序员宅基地

- jenkins详解-程序员宅基地

- asp控件Repeater运用-程序员宅基地

- 【数据结构】——二叉搜索树-程序员宅基地

- Win7 自带FTP将文件复制到FTP服务器时发生错误。-程序员宅基地

- Python3+Selenium3自动化测试-(三)-程序员宅基地

- 深度学习论文翻译解析(二):An End-to-End Trainable Neural Network for Image-based Sequence Recognition and Its Ap...-程序员宅基地

- dom4j生成、解析xml-程序员宅基地

- vscode代码格式化js自动换行问题_vscode格式化定义js换行规则-程序员宅基地