Hive是Shark的前身,Shark是SparkSQL的前身 Shark是基于Spark计算框架之上且兼容Hive语法的SQL执行引擎,由 于底层的计算采用了Spark,性能比MapReduce的Hive普遍快2倍以上, 当数据全部load在内存的话,将快10倍...

”jsonRDD转换成DataFrame“ 的搜索结果

在项目中,自定义数据采集以及为下游sink提供结构化的数据的需求,目前主要采用dataframe和JSON互相转换从而便于数据的分析。 1、JSON字符串转dataframe 首先需要了解json对应于dataframe的数据类型: json ...

** ************************ student表结构*****************************//** ************************ course表结构*****************************//** ************************ teacher表结构****************...

spark中Dstream、RDD、DataFrame之间的转换

import org.apache.hadoop.hive.ql.parse.HiveParser.rowFormat_return; import org.apache.spark.SparkConf;...import org.apache.spark.api.java.JavaRDD; import org.apache.spark.api.java.J...

让Spark具备了处理大规模结构化数据的能力,不仅比原有的RDD转化方式更加简单易用,而且获得了更高的计算性能Spark能够轻松实现从MySQL到DataFrame的转化,并且支持SQL查询,DataFrame实际上就是对RDD的封装。...

2、将 RDD转换为 DataFrame,并指定列名为。(1)as方法:将DataFrame转换为DataSet,使用。(2)toDF方法:将DataSet转换为DataFrame。(1)toDF方法:将RDD转换为DataFrame;(2)rdd方法:将DataFrame转换为RDD。...

方式一: 通过case class创建DataFrames(反射) TestDataFrame1.scala ... // 隐式类的导入 // 定义case class,相当于表结构 case class Dept(var id:Int, var position:String, var location:String) ...

一、RDD转换为DataFrame 为什么要将RDD转换为DataFrame?因为这样的话,我们就可以直接针对HDFS等任何可以构建为RDD的数据,使用Spark SQL进行SQL查询了。这个功能是无比强大的。想象一下,针对HDFS中的数据,直接...

Spark官网提供了两种方法来实现从RDD转换得到DataFrame,第一种方法是,利用反射来推断包含特定类型对象的RDD的schema;第二种方法是,使用编程接口,构造一个schema并将其应用在已知的RDD上。 利用反射机制推断RDD...

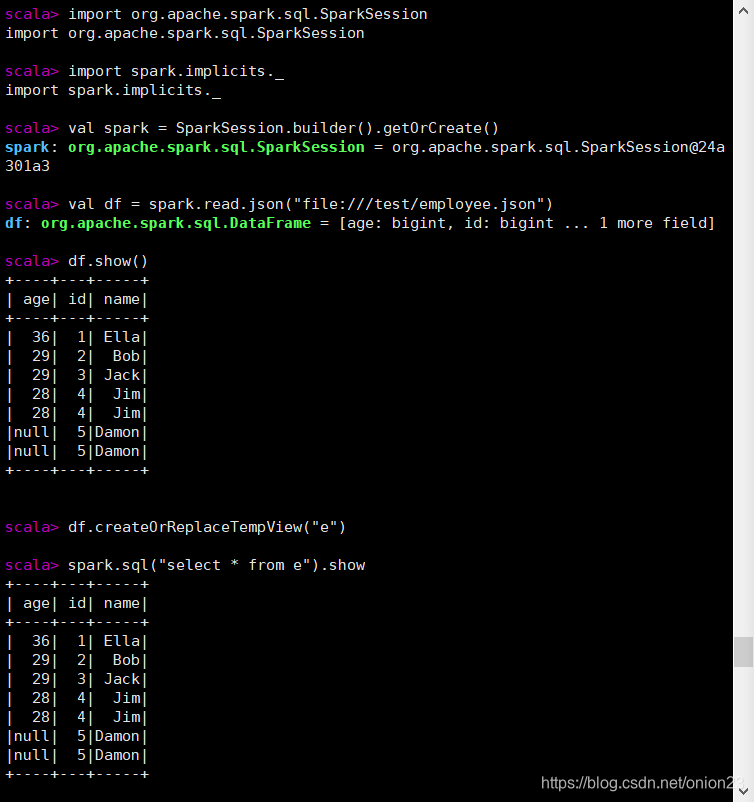

文章目录1 、SparkSQL读取Json文件2、RDD转换成DataFrame2.1 用toDF()方式2.2 把原生RDD转换成RDD[Row],再和定义好的StructType匹配 1 、SparkSQL读取Json文件 先随便造两份Json格式数据。 [hadoop@vm01 data]$ ...

退出spark-shell :quit 使用spark自带文件 [hadoop@hadoop000 resources]$ pwd /home/hadoop/app/spark-2.4.0-bin-2.6.0-cdh5.7.0/... val df = spark.read.json("file:///hom

Spark官网提供了两种方法来实现从RDD转换得到DataFrame,第一种方法是,利用反射来推断包含特定类型对象的RDD的schema,适用对已知数据结构的RDD转换;第二种方法是,使用编程接口,构造一个schema并将其应用在已知...

RDD2.1 创建RDD2.1.1 通过读取DataFrame二级目录三级目录 RDD 1. SparkSession 使用Spark核心API的应用以SparkContext对象作为程序主入口,而Spark SQL应用则以SparkSession对象作为程序主入口,在Spark2.0发布之前...

RDD转换成DataFrame的两种方式2.DataSet的创建3.类型之间的转换总结4.RDD、DataFrame、DataSet三者的共性与区别共性:区别:RDD:DataFrame:Dataset: 1. RDD转换成DataFrame的两种方式 rdd可以通过下面这种方式得到...

[返回Spark教程首页]Spark官网提供了两种方法来实现从RDD转换得到DataFrame,第一种方法是,利用反射来推断包含特定类型对象的RDD的schema,适用对已知数据结构的RDD转换;第二种方法是,使用编程接口,构造一个...

使用spark1.x版本的方式 测试数据目录:/home/hadoop/apps/spark/examples/src/main/resources(spark的安装目录里面)people.txt 3.1 方式一:通过case class创建DataFrames(反射) ...//定义case class,...

我是要将rdd转换成dataframe,如果是Person 类型代码能执行,但是我本身想用map或者json来封装数据,不想使用具体类型 但是改成map之后提示异常,我想问下用什么方式能够使用Map格式的数据。 java.lang....

通过反射的方式将非json格式的RDD转换成DataFrame(不建议使用) 自定义类要可序列化 自定义类的访问级别是Public RDD转成DataFrame后会根据映射将字段按Assci码排序 将DataFrame转换成RDD时获取字段两种方式,一...

[返回Spark教程首页]Spark官网提供了两种方法来实现从RDD转换得到DataFrame,第一种方法是,利用反射来推断包含特定类型对象的RDD的schema,适用对已知数据结构的RDD转换;第二种方法是,使用编程接口,构造一个...

Java版本 SparkConf conf = new SparkConf(); conf.setMaster("local").setAppName("rddStruct");...JavaSparkContext sc = new JavaSparkContext(conf);...JavaRDD<St...

首先拿到sql后解析一批未被解决的逻辑计划,再经过分析得到分析后的逻辑计划,再经过一批优化规则转换成一批最佳优化的逻辑计划,再经过SparkPlanner的策略转化成一批物理计划,随后经过消费模型转换成一个个的Spark...

spark json字会串转dataframe,dataframe结构转json处理 package mongo import org.apache.spark.sql.SparkSession object InsertTable { def main(args: Array[String]): Unit = { val spark = SparkSession....

作为数据挖掘工程师,以后必不可免要用到并行计算,pyspark是python操作spark的API,本人因此入了坑。 1 pyspark的安装 见我另一篇博客:... 2 spark概述 Spark 允许用户读取、转换和 聚合数据,可以轻松...

本实验的目的是掌握Spark SQL的基本编程方法,熟悉RDD到DataFrame的转化方法,熟悉利用Spark SQL管理来自不同数据源的数据。

文章目录一、sparksql概述二、sparksql四大特性三、DataFrame简介DataFrame与RDD的区别DataFrame与RDD的优缺点读取数据源创建DataFrame读取json文件创建DataFrame四、DataFrame常用操作DSL风格语法SQL风格语法六、...

推荐文章

- 关于HashMap的加载因子相关理解_hashmap加载因子-程序员宅基地

- python一二三【warning模块使用】_import warnings-程序员宅基地

- ssm常用的注解_ssm框架注解-程序员宅基地

- opengl菜单出现乱码_opengl文字显示(二) | 学步园-程序员宅基地

- MySQL 团队开发规范_group by后面的字段最好是索引列-程序员宅基地

- Java入门到精通——第十五单元 多态(没有十四哦)_多态技能目标-程序员宅基地

- 热点!《北京市电子印章推广应用行动方案(试行)》发布_电子印章推广方案-程序员宅基地

- Android实现退出整个程序的方法_activity直接退出整个app-程序员宅基地

- 【GUI软件】小红书评论采集:自动采集10000多条,含二级评论!-程序员宅基地

- cuda java_在Nvidia GPU上使用Java(CUDA)-程序员宅基地