”Attention“ 的搜索结果

基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+...

本文力图帮助大家轻松理解自注意力机制

也就是说,查询、键、和值都来自于同一个地方,即输入序列和输出序列是相同的,即模型在生成每一个输出时都对自己的所有输入(包括自己)进行加权求和。...2. Q,K,V需要遵循attention的做法。1. Q=K=V(同源)

attention_mul = attention_3d_block(lstm_out) attention_mul = Flatten()(attention_mul) output = Dense(60, activation='linear')(attention_mul) model = Model(inputs=[inputs], outputs=output) return ...

基于相关性分析的CNN_Attention_LSTM期货价格预测模型python源码+数据集+模型+详细注释.zip代码完整下载可用确保可以运行。 基于相关性分析的CNN_Attention_LSTM期货价格预测模型python源码+数据集+模型+详细注释....

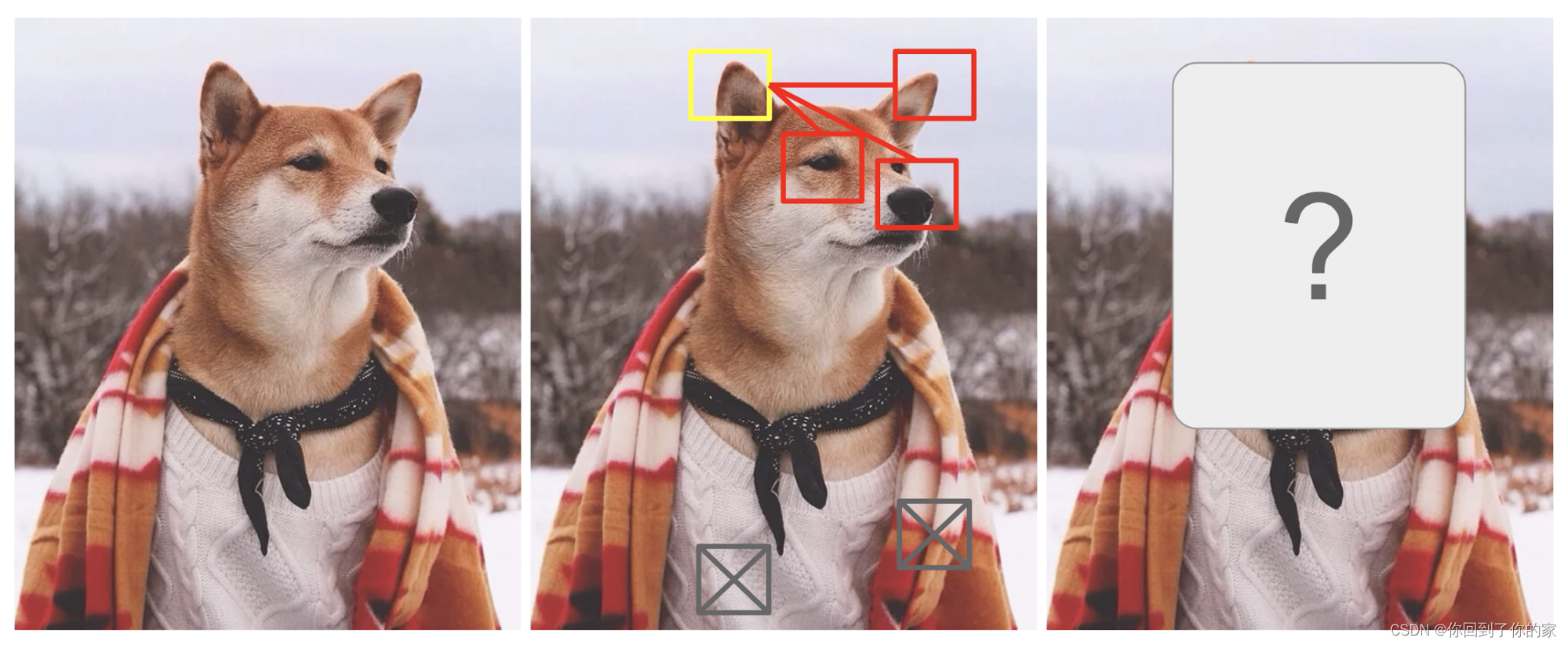

说到Attention可能大家想到的是最经典的Attention模型,实际上Attention有很多变种,Attention也有很多种计算方法,包括近来大火的self-attention也是Attention的一种,下面我会由浅到深的介绍各种Attention机制,...

Attention注意力机制,在传统的CNN模型和transform模型中均广泛使用。本文就主要对基于transform的注意力机制进行展开: 1. Attention是什么 2. Attention为什么要引入到语音领域 3. Attention的优点 4. transform与...

基于双阶段注意力的循环神经网络 Pytorch实现

模型以及代码结构的高清大图

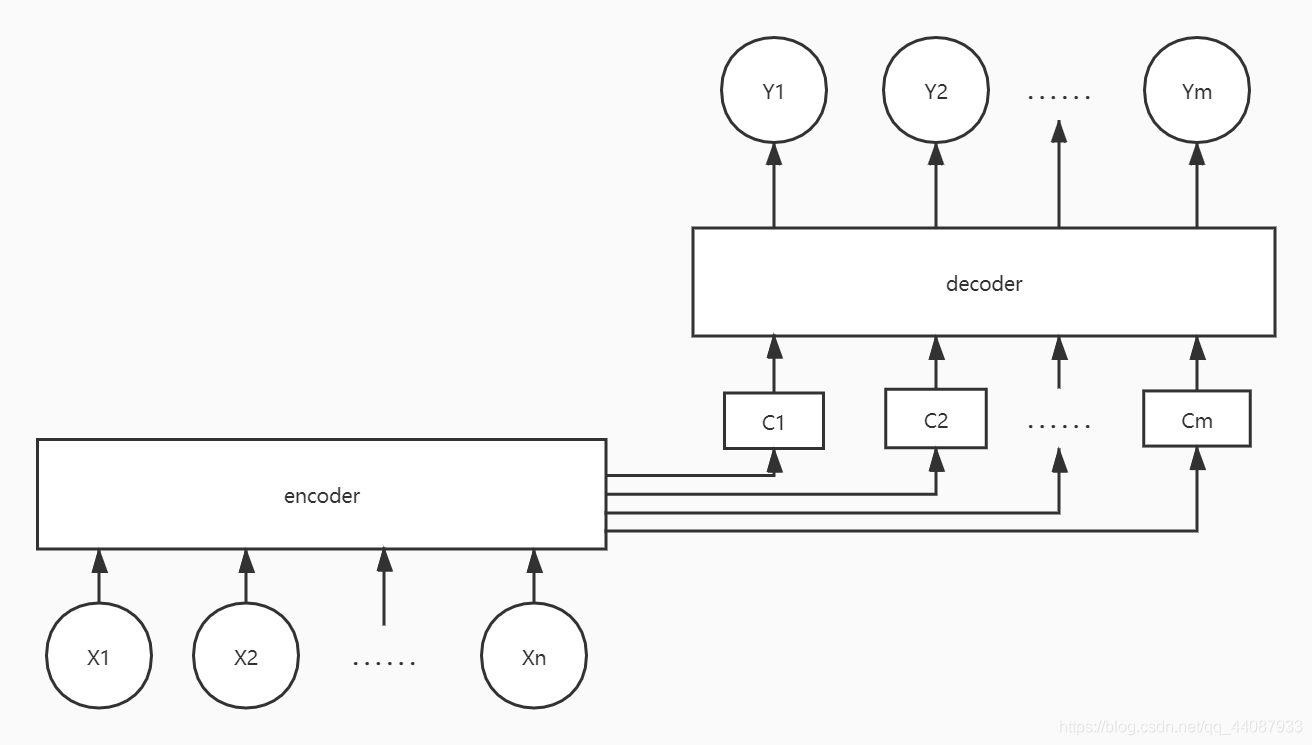

传统seq2seq模型中encoder将输入序列编码成一个context向量,decoder将context向量作为初始隐状态,生成目标序列。随着输入序列长度的增加,编码器难以将所有输入信息编码为单一context向量,编码信息缺失,难以完成...

Relational Graph Attention Networks -- deep learning

Mixed High-Order Attention Network for Person Re-Identification CVPR2020

推荐文章

- 大数据技术未来发展前景及趋势分析_大数据技术的发展方向-程序员宅基地

- Abaqus学习-初识Abaqus(悬臂梁)_abaqus悬臂梁-程序员宅基地

- 数据预处理--数据格式csv、arff等之间的转换_csv转arff文件-程序员宅基地

- c语言发送网络请求,如何使用C+发出HTTP请求?-程序员宅基地

- ccc计算机比赛如何报名,整理:加拿大的CCC是什么,怎么报名?-程序员宅基地

- RK3568 学习笔记 : ubuntu 20.04 下 Linux-SDK 镜像烧写_rk3568刷linux-程序员宅基地

- Gradle是什么_gradle是干嘛的-程序员宅基地

- adb命令集锦-程序员宅基地

- 【Java基础学习打卡15】分隔符、标识符与关键字_java分隔符有哪三种-程序员宅基地

- Python批量改变图片名字_python批量修改图片名称-程序员宅基地