Python爬虫——scrapy-4-程序员宅基地

技术标签: 爬虫 阿里云 python Python爬虫 Python之路 scrapy

目录

免责声明

本文章仅用于学习交流,无任何商业用途

目标

这次我们要学习把爬取到的数据存入数据库之中

过程

先修改配置文件

settings中添加下面的内容

# todo 配置 mysql数据库 # 这里是我的阿里云地址,你填你mysql的地址 DB_HOST = 'xx.xx.xx.xx' DB_PORT = 3306 DB_USER = 'root' DB_PASSWORD = '12345678' DB_NAME = 'spider01' DB_CHARSET = 'utf-8'

再修改pipelines.py

添加下面的代码

class MysqlPipeline:

def process_item(self, item, spider):

return item再添加配置

ITEM_PIPELINES = {

"scrapy_readbook_090.pipelines.ScrapyReadbook090Pipeline": 300,

# MysqlPipeline

"scrapy_readbook_090.pipelines.MysqlPipeline": 301

}

。。。。

最后的结果是这样的

read.py

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from scrapy_readbook_090.items import ScrapyReadbook090Item

class ReadSpider(CrawlSpider):

name = "read"

allowed_domains = ["www.dushu.com"]

start_urls = ["https://www.dushu.com/book/1188_1.html"]

rules = (Rule(LinkExtractor(allow=r"/book/1188_\d+\.html"),

callback="parse_item",

# true代表是否跟进

# 打开follow为true就会爬取全部网页

follow=True),)

def parse_item(self, response):

img_list = response.xpath('//div[@class="bookslist"]//img')

for img in img_list:

name = img.xpath('./@alt').extract_first()

img_src = img.xpath('./@data-original').extract_first()

book = ScrapyReadbook090Item(name=name, src=img_src)

yield book

pipelines.py

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/latest/topics/item-pipeline.html

# useful for handling different item types with a single interface

from itemadapter import ItemAdapter

class ScrapyReadbook090Pipeline:

def open_spider(self, spider):

self.fp = open('book.json', 'w', encoding='utf-8')

def process_item(self, item, spider):

self.fp.write(str(item))

return item

def close_spider(self, spider):

self.fp.close()

# 加载settings文件

from scrapy.utils.project import get_project_settings

import pymysql

class MysqlPipeline:

def open_spider(self, spider):

settings = get_project_settings()

self.host = settings['DB_HOST']

self.port = settings['DB_PORT']

self.user = settings['DB_USER']

self.password = settings['DB_PASSWORD']

self.name = settings['DB_NAME']

self.charset = settings['DB_CHARSET']

self.connect()

def connect(self):

self.conn = pymysql.connect(

host=self.host,

port=self.port,

user=self.user,

password=self.password,

db=self.name,

charset=self.charset

)

# 可执行sql语句

self.cursor = self.conn.cursor()

def process_item(self, item, spider):

sql = 'insert into book2(name,src) values("{}","{}")'.format(item['name'], item['src'])

# 执行SQL语句

self.cursor.execute(sql)

# 提交

self.conn.commit()

return item

def close_spider(self, spider):

self.cursor.close()

self.conn.close()

items.py

# Define here the models for your scraped items

#

# See documentation in:

# https://docs.scrapy.org/en/latest/topics/items.html

import scrapy

class ScrapyReadbook090Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

src = scrapy.Field()

settings.py

# Scrapy settings for scrapy_readbook_090 project

#

# For simplicity, this file contains only settings considered important or

# commonly used. You can find more settings consulting the documentation:

#

# https://docs.scrapy.org/en/latest/topics/settings.html

# https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

# https://docs.scrapy.org/en/latest/topics/spider-middleware.html

BOT_NAME = "scrapy_readbook_090"

SPIDER_MODULES = ["scrapy_readbook_090.spiders"]

NEWSPIDER_MODULE = "scrapy_readbook_090.spiders"

# Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = "scrapy_readbook_090 (+http://www.yourdomain.com)"

# Obey robots.txt rules

ROBOTSTXT_OBEY = True

# Configure maximum concurrent requests performed by Scrapy (default: 16)

#CONCURRENT_REQUESTS = 32

# Configure a delay for requests for the same website (default: 0)

# See https://docs.scrapy.org/en/latest/topics/settings.html#download-delay

# See also autothrottle settings and docs

#DOWNLOAD_DELAY = 3

# The download delay setting will honor only one of:

#CONCURRENT_REQUESTS_PER_DOMAIN = 16

#CONCURRENT_REQUESTS_PER_IP = 16

# Disable cookies (enabled by default)

#COOKIES_ENABLED = False

# Disable Telnet Console (enabled by default)

#TELNETCONSOLE_ENABLED = False

# Override the default request headers:

#DEFAULT_REQUEST_HEADERS = {

# "Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8",

# "Accept-Language": "en",

#}

# Enable or disable spider middlewares

# See https://docs.scrapy.org/en/latest/topics/spider-middleware.html

#SPIDER_MIDDLEWARES = {

# "scrapy_readbook_090.middlewares.ScrapyReadbook090SpiderMiddleware": 543,

#}

# Enable or disable downloader middlewares

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

#DOWNLOADER_MIDDLEWARES = {

# "scrapy_readbook_090.middlewares.ScrapyReadbook090DownloaderMiddleware": 543,

#}

# Enable or disable extensions

# See https://docs.scrapy.org/en/latest/topics/extensions.html

#EXTENSIONS = {

# "scrapy.extensions.telnet.TelnetConsole": None,

#}

# todo 配置 mysql数据库

DB_HOST = '8.137.20.36'

# 端口号要是整形

DB_PORT = 3306

DB_USER = 'root'

DB_PASSWORD = '12345678'

DB_NAME = 'spider01'

# utf-8的 - 不要写

DB_CHARSET = 'utf8'

# Configure item pipelines

# See https://docs.scrapy.org/en/latest/topics/item-pipeline.html

ITEM_PIPELINES = {

"scrapy_readbook_090.pipelines.ScrapyReadbook090Pipeline": 300,

# MysqlPipeline

"scrapy_readbook_090.pipelines.MysqlPipeline": 301

}

# Enable and configure the AutoThrottle extension (disabled by default)

# See https://docs.scrapy.org/en/latest/topics/autothrottle.html

#AUTOTHROTTLE_ENABLED = True

# The initial download delay

#AUTOTHROTTLE_START_DELAY = 5

# The maximum download delay to be set in case of high latencies

#AUTOTHROTTLE_MAX_DELAY = 60

# The average number of requests Scrapy should be sending in parallel to

# each remote server

#AUTOTHROTTLE_TARGET_CONCURRENCY = 1.0

# Enable showing throttling stats for every response received:

#AUTOTHROTTLE_DEBUG = False

# Enable and configure HTTP caching (disabled by default)

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html#httpcache-middleware-settings

#HTTPCACHE_ENABLED = True

#HTTPCACHE_EXPIRATION_SECS = 0

#HTTPCACHE_DIR = "httpcache"

#HTTPCACHE_IGNORE_HTTP_CODES = []

#HTTPCACHE_STORAGE = "scrapy.extensions.httpcache.FilesystemCacheStorage"

# Set settings whose default value is deprecated to a future-proof value

REQUEST_FINGERPRINTER_IMPLEMENTATION = "2.7"

TWISTED_REACTOR = "twisted.internet.asyncioreactor.AsyncioSelectorReactor"

FEED_EXPORT_ENCODING = "utf-8"

最后是找到了4000条数据

可能是io进服务器的顺序问题,军娃不是最后一个,但是一页40本书,一共100页也是没有一点毛病了。(* ^ ▽ ^ *)

scrapy日志信息以及日志级别

Scrapy是一个基于Python的网络爬虫框架,它提供了强大的日志功能。Scrapy的日志信息以及日志级别如下:

-

DEBUG:调试级别,用于输出详细的调试信息,一般在开发和测试阶段使用。

-

INFO:信息级别,用于输出一些重要的信息,如爬虫的启动信息、请求的URL等。

-

WARNING:警告级别,用于输出一些不太严重的警告信息,如某个网页的解析出错,但不影响整个爬虫的执行。

-

ERROR:错误级别,用于输出一些错误信息,如爬虫的配置出错、网络连接异常等。

-

CRITICAL:严重级别,用于输出一些非常严重的错误信息,如爬虫的关键逻辑出错、无法连接到目标网站等。

默认的日志级别是DEBUG

Scrapy的日志信息可以在控制台中直接输出,也可以保存到文件中。可以通过设置Scrapy的配置文件或使用命令行参数来调整日志级别和输出方式。

以下是Scrapy的日志信息的示例:

2021-01-01 12:00:00 [scrapy.core.engine] INFO: Spider opened

2021-01-01 12:00:01 [scrapy.core.engine] DEBUG: Crawled 200 OK

2021-01-01 12:00:01 [scrapy.core.engine] DEBUG: Crawled 404 Not Found

2021-01-01 12:00:02 [scrapy.core.engine] WARNING: Ignoring response <404 Not Found>

2021-01-01 12:00:02 [scrapy.core.engine] DEBUG: Crawled 200 OK

2021-01-01 12:00:02 [scrapy.core.engine] ERROR: Spider error processing <GET http://example.com>: Error parsing HTML

2021-01-01 12:00:03 [scrapy.core.engine] DEBUG: Crawled 200 OK

2021-01-01 12:00:03 [scrapy.core.engine] INFO: Closing spider (finished)

2021-01-01 12:00:03 [scrapy.statscollectors] INFO: Dumping Scrapy stats

settings.py文件设置

默认的级别是DEBUG,会显示上面的所有信息

在配置文件中 settings.py

LOG_FILE : 将屏幕显示的信息全部记录到文件中,屏幕不再显示,注意文件后最有一定是 .log

LOG_LEVEL : 设置日志的等级,就是显示那些,不显示那些

用百度实验一下

先把 “君子协议” 撕碎

# ROBOTSTXT_OBEY = True指定日志级别

WARNING

在settings.py中添加下述代码

# 指定日志的级别

LOG_LEVEL = 'WARNING'

==========是我在log.py中添加要打印的

就可以发现没有日志了

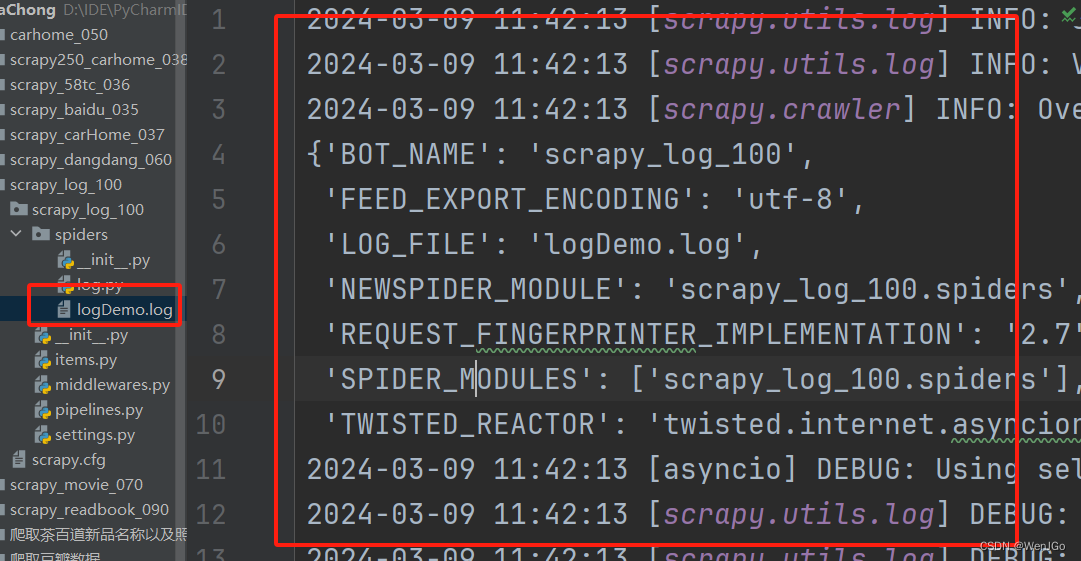

日志文件

我们先把上面配置的等级删除掉,再加上下述的代码

# 日志文件

LOG_FILE = 'logDemo.log'运行

世界依然清晰

但是日志已经存储在日志文件中了

注意

其实一般来说不要修改log的等级,如果报错也太难发现是什么问题了,所以一般为了控制台别打印那么多东西

scrapy的post请求

简介

在Scrapy中进行POST请求可以通过scrapy.FormRequest类来实现。下面是一个使用Scrapy进行POST请求的示例:

import scrapy

class MySpider(scrapy.Spider):

name = 'example.com'

start_urls = ['http://www.example.com/login']

def parse(self, response):

# 提取登录页的csrf token

csrf_token = response.css('input[name="csrf_token"]::attr(value)').get()

# 构建POST请求的表单数据

formdata = {

'username': 'myusername',

'password': 'mypassword',

'csrf_token': csrf_token

}

# 发送POST请求

yield scrapy.FormRequest(url='http://www.example.com/login', formdata=formdata, callback=self.after_login)

def after_login(self, response):

# 检查登录是否成功

if response.url == 'http://www.example.com/home':

self.log('Login successful')

# 处理登录成功后的响应数据

# ...

else:

self.log('Login failed')

在上面的示例中,首先在parse方法中抓取登录页,并提取登录页的csrf token。然后构建一个包含用户名、密码和csrf token的字典,作为formdata参数传递给FormRequest对象。最后使用yield关键字发送POST请求,并指定回调函数after_login来处理登录后的响应。

在after_login方法中,可以根据响应的URL来判断登录是否成功。如果URL为登录后的首页URL,则登录成功,否则登录失败。可以在登录成功时做进一步的处理,如抓取用户信息,然后在控制台或日志中输出相应的信息。

需要注意的是,Scrapy的POST请求默认使用application/x-www-form-urlencoded方式来编码数据。如果需要发送JSON或其他类型的请求,可以通过设置headers参数来指定请求头,如:yield scrapy.FormRequest(url='http://www.example.com/login', formdata=formdata, headers={'Content-Type': 'application/json'}, callback=self.after_login)。

另外,如果需要在POST请求中上传文件,可以使用scrapy.FormRequest的files参数,将文件的路径作为值传递给表单字段。更多关于POST请求的用法和参数配置,请查阅Scrapy官方文档。

爬取百度翻译

只需要修改testpost.py这个自己创建的文件就行了

import scrapy

import json

class TestpostSpider(scrapy.Spider):

name = "testpost"

allowed_domains = ["fanyi.baidu.com"]

# post请求如果没有参数,那抹这个请求将没有任何的意义

# 所以 start_urls 也是没有用

# 而且 parse 方法也没有用了

# 所以直接注释掉

# TODO

# start_urls = ["https://fanyi.baidu.com/sug"]

#

# def parse(self, response):

# print("==========================")

# post请求就使用这个方法

def start_requests(self):

url = 'https://fanyi.baidu.com/sug'

data = {

'kw': 'final'

}

yield scrapy.FormRequest(url=url, formdata=data, callback=self.parse_second)

def parse_second(self, response):

content = response.text

obj = json.loads(content, encoding='utf-8')

print(obj)

总结

从2月29号,到今天3月9号,一共过去了十天,完成了爬虫的入门,从urllib到scrapy,这条路很长但是也很简单,中间的配置Python软件包的版本问题时常可以阻碍我的脚步,但是我都一一将他们解决,困难毕竟只是困难,人定胜天,我命由我不由天,加油!!!ヾ(◍°∇°◍)ノ゙

ヾ( ̄▽ ̄)Bye~Bye~

完结撒花

智能推荐

oracle 12c 集群安装后的检查_12c查看crs状态-程序员宅基地

文章浏览阅读1.6k次。安装配置gi、安装数据库软件、dbca建库见下:http://blog.csdn.net/kadwf123/article/details/784299611、检查集群节点及状态:[root@rac2 ~]# olsnodes -srac1 Activerac2 Activerac3 Activerac4 Active[root@rac2 ~]_12c查看crs状态

解决jupyter notebook无法找到虚拟环境的问题_jupyter没有pytorch环境-程序员宅基地

文章浏览阅读1.3w次,点赞45次,收藏99次。我个人用的是anaconda3的一个python集成环境,自带jupyter notebook,但在我打开jupyter notebook界面后,却找不到对应的虚拟环境,原来是jupyter notebook只是通用于下载anaconda时自带的环境,其他环境要想使用必须手动下载一些库:1.首先进入到自己创建的虚拟环境(pytorch是虚拟环境的名字)activate pytorch2.在该环境下下载这个库conda install ipykernelconda install nb__jupyter没有pytorch环境

国内安装scoop的保姆教程_scoop-cn-程序员宅基地

文章浏览阅读5.2k次,点赞19次,收藏28次。选择scoop纯属意外,也是无奈,因为电脑用户被锁了管理员权限,所有exe安装程序都无法安装,只可以用绿色软件,最后被我发现scoop,省去了到处下载XXX绿色版的烦恼,当然scoop里需要管理员权限的软件也跟我无缘了(譬如everything)。推荐添加dorado这个bucket镜像,里面很多中文软件,但是部分国外的软件下载地址在github,可能无法下载。以上两个是官方bucket的国内镜像,所有软件建议优先从这里下载。上面可以看到很多bucket以及软件数。如果官网登陆不了可以试一下以下方式。_scoop-cn

Element ui colorpicker在Vue中的使用_vue el-color-picker-程序员宅基地

文章浏览阅读4.5k次,点赞2次,收藏3次。首先要有一个color-picker组件 <el-color-picker v-model="headcolor"></el-color-picker>在data里面data() { return {headcolor: ’ #278add ’ //这里可以选择一个默认的颜色} }然后在你想要改变颜色的地方用v-bind绑定就好了,例如:这里的:sty..._vue el-color-picker

迅为iTOP-4412精英版之烧写内核移植后的镜像_exynos 4412 刷机-程序员宅基地

文章浏览阅读640次。基于芯片日益增长的问题,所以内核开发者们引入了新的方法,就是在内核中只保留函数,而数据则不包含,由用户(应用程序员)自己把数据按照规定的格式编写,并放在约定的地方,为了不占用过多的内存,还要求数据以根精简的方式编写。boot启动时,传参给内核,告诉内核设备树文件和kernel的位置,内核启动时根据地址去找到设备树文件,再利用专用的编译器去反编译dtb文件,将dtb还原成数据结构,以供驱动的函数去调用。firmware是三星的一个固件的设备信息,因为找不到固件,所以内核启动不成功。_exynos 4412 刷机

Linux系统配置jdk_linux配置jdk-程序员宅基地

文章浏览阅读2w次,点赞24次,收藏42次。Linux系统配置jdkLinux学习教程,Linux入门教程(超详细)_linux配置jdk

随便推点

matlab(4):特殊符号的输入_matlab微米怎么输入-程序员宅基地

文章浏览阅读3.3k次,点赞5次,收藏19次。xlabel('\delta');ylabel('AUC');具体符号的对照表参照下图:_matlab微米怎么输入

C语言程序设计-文件(打开与关闭、顺序、二进制读写)-程序员宅基地

文章浏览阅读119次。顺序读写指的是按照文件中数据的顺序进行读取或写入。对于文本文件,可以使用fgets、fputs、fscanf、fprintf等函数进行顺序读写。在C语言中,对文件的操作通常涉及文件的打开、读写以及关闭。文件的打开使用fopen函数,而关闭则使用fclose函数。在C语言中,可以使用fread和fwrite函数进行二进制读写。 Biaoge 于2024-03-09 23:51发布 阅读量:7 ️文章类型:【 C语言程序设计 】在C语言中,用于打开文件的函数是____,用于关闭文件的函数是____。

Touchdesigner自学笔记之三_touchdesigner怎么让一个模型跟着鼠标移动-程序员宅基地

文章浏览阅读3.4k次,点赞2次,收藏13次。跟随鼠标移动的粒子以grid(SOP)为partical(SOP)的资源模板,调整后连接【Geo组合+point spirit(MAT)】,在连接【feedback组合】适当调整。影响粒子动态的节点【metaball(SOP)+force(SOP)】添加mouse in(CHOP)鼠标位置到metaball的坐标,实现鼠标影响。..._touchdesigner怎么让一个模型跟着鼠标移动

【附源码】基于java的校园停车场管理系统的设计与实现61m0e9计算机毕设SSM_基于java技术的停车场管理系统实现与设计-程序员宅基地

文章浏览阅读178次。项目运行环境配置:Jdk1.8 + Tomcat7.0 + Mysql + HBuilderX(Webstorm也行)+ Eclispe(IntelliJ IDEA,Eclispe,MyEclispe,Sts都支持)。项目技术:Springboot + mybatis + Maven +mysql5.7或8.0+html+css+js等等组成,B/S模式 + Maven管理等等。环境需要1.运行环境:最好是java jdk 1.8,我们在这个平台上运行的。其他版本理论上也可以。_基于java技术的停车场管理系统实现与设计

Android系统播放器MediaPlayer源码分析_android多媒体播放源码分析 时序图-程序员宅基地

文章浏览阅读3.5k次。前言对于MediaPlayer播放器的源码分析内容相对来说比较多,会从Java-&amp;gt;Jni-&amp;gt;C/C++慢慢分析,后面会慢慢更新。另外,博客只作为自己学习记录的一种方式,对于其他的不过多的评论。MediaPlayerDemopublic class MainActivity extends AppCompatActivity implements SurfaceHolder.Cal..._android多媒体播放源码分析 时序图

java 数据结构与算法 ——快速排序法-程序员宅基地

文章浏览阅读2.4k次,点赞41次,收藏13次。java 数据结构与算法 ——快速排序法_快速排序法