使用python3爬取网页,利用aria2下载电影,Jellyfin自动更新最新电影_jellyfin自动播放下一集-程序员宅基地

前言:在我搭建好Jellyfin软件后,因为只能播放本地视频,就想能不能播放网络上的电影,可以每天自动下载并更新,这样就不用我手工下载好,再上传到NAS中播放。或许有更好的方法,那就是直接用电影播放源,那就有个问题了,没有那个视频网愿意给播放源,所以还是自己慢慢下载后再播放吧。个人对于python语言也是小白,在网络上寻找大神的脚本稍加修改得到的。

如果需要搭建jellyfin,请看我之前的博客-家庭影院Jellyfin搭建,linux网页视频播放器。

环境:centos7

工具:python3、jellyfin、shell脚本、aria2

1、安装python3

默认安装好centos7系统后,自带有python2.7.5的版本,所以需要安装python3的版本。2.7.5的版本不能删除,否则centos系统会崩溃。请从官网下载python3.8版本。

关于python2升级至python3,会有一些问题,但都能解决,请参考以下资料:

2)pbzip2: error while loading shared libraries: libbz2.so.1.0: cannot open shared object file

3)centos7安装python3及其配置pip(建立软连接)

2、编辑python脚本

命名脚本为movie.py,将以下复制到py脚本保存,执行python3 movie.py。查看爬取结果,是否生成文件。

脚本不是我编写的,是借鉴大神,然后根据电影天堂现在的地址和信息,做了一些改动,获取下载电影地址

# encoding: gbk

# 我们用到的库

import requests

import bs4

import re

import pandas as pd

def get_data(url):

'''

功能:访问 url 的网页,获取网页内容并返回

参数:

url :目标网页的 url

返回:目标网页的 html 内容

'''

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

}

try:

r = requests.get(url, headers=headers)

r.raise_for_status()

r.encoding = 'gbk'

return r.text

except requests.HTTPError as e:

print(e)

print("HTTPError")

except requests.RequestException as e:

print(e)

except:

print("Unknown Error !")

def parse_data(html):

'''

功能:提取 html 页面信息中的关键信息,并整合一个数组并返回

参数:html 根据 url 获取到的网页内容

返回:存储有 html 中提取出的关键信息的数组

'''

bsobj = bs4.BeautifulSoup(html,'html.parser')

info = []

# 获取电影列表

tbList = bsobj.find_all('table', attrs = {'class': 'tbspan'})

# 对电影列表中的每一部电影单独处理

for item in tbList:

movie = []

link = item.b.find_all('a')[0]

# 获取电影的名称

name = link.string

# 获取详情页面的 url

url = 'https://www.dytt8.net' + link["href"]

# 将数据存放到电影信息列表里

movie.append(name)

movie.append(url)

try:

# 访问电影的详情页面,查找电影下载的磁力链接

temp = bs4.BeautifulSoup(get_data(url),'html.parser')

tbody = temp.find_all('a')

print(tbody)

#^magnet.*?fannouce

# 下载链接有多个(也可能没有),这里将所有链接都放进来

for i in tbody:

lines = i.get("href")

if "magnet" in lines:

#download = lines.a.text

#print(lines)

movie.append(lines)

print(movie)

# 将此电影的信息加入到电影列表中

info.append(movie)

except Exception as e:

print(e)

return info

def save_data(data):

'''

功能:将 data 中的信息输出到文件中/或数据库中。

参数:data 将要保存的数据

'''

filename = 'C:/Users/Administrator/Desktop/movie.txt'

dataframe = pd.DataFrame(data)

dataframe.to_csv(filename, mode='a', index=False, sep=';', header=False)

def main():

# 循环爬取多页数据

#for page in range(1, 114):

# print('正在爬取:第' + str(page) + '页......')

# 根据之前分析的 URL 的组成结构,构造新的 url

#if page == 1:

# index = 'index'

#else:

# index = 'index_' + str(page)

# url = 'https://www.dy2018.com/2/'+ index +'.html'

#url='https://www.dy2018.com/2/index.html'

url='https://www.dytt8.net/html/gndy/dyzz/index.html'

# 依次调用网络请求函数,网页解析函数,数据存储函数,爬取并保存该页数据

html = get_data(url)

movies = parse_data(html)

save_data(movies)

#print('第' + str(page) + '页完成!')

if __name__ == '__main__':

print('爬虫启动成功!')

main()

print('爬虫执行完毕!')

3、安装aria2

安装教程,请访问我的博客第一条,安装nextcloud里面有详细的安装aria2教程

4、编写aria2下载的shell脚本

#!/bin/bash

cd /downloads

count=0

#/root/shell/movie.txt,这个地址是movie.py执行后生成的下载地址,请根据你实际的地址填写

route=/root/shell/movie.txt

name=(`awk -F ";" '{print $1}' $route | cut -d '《' -f2|cut -d '》' -f1 | cut -d '/' -f1`)

addr=(`awk -F ";" '{print $3}' $route`)

nr=`awk '{print NR}' $route | tail -n1`

prop=`awk -F ";" '{print $3}' $route | cut -d '&' -f2 | awk -F "." '{print $8}'`

for ((i=0; i<=nr; i++))

do

let count++

echo "正在下载第$count个电影,《${name[$i]}》"

sudo -u www nohup aria2c -o "${name[$i]}.${prop[$i]}" "${addr[$i]}" &

echo "第$count个电影完成创建,转后台下载中"

sleep 2

done

rm -rf /root/shell/movie.txt5、测试

执行脚本,请注意先后顺序,先执行python3 movie.py。等待爬取下载电影地址完成后,执行sh movie.sh。

6、增加自动任务,添加到crontab

crontab -e中增加以下信息,获取这个方法不完善,但仍在改进

#每2天运行python脚本,获取电影天堂下载地址

20 1 */2 * * python3 /root/shell/movie.py

#每2天运行一次aria2下载电影

30 1 */2 * * sh /root/shell/movie.sh

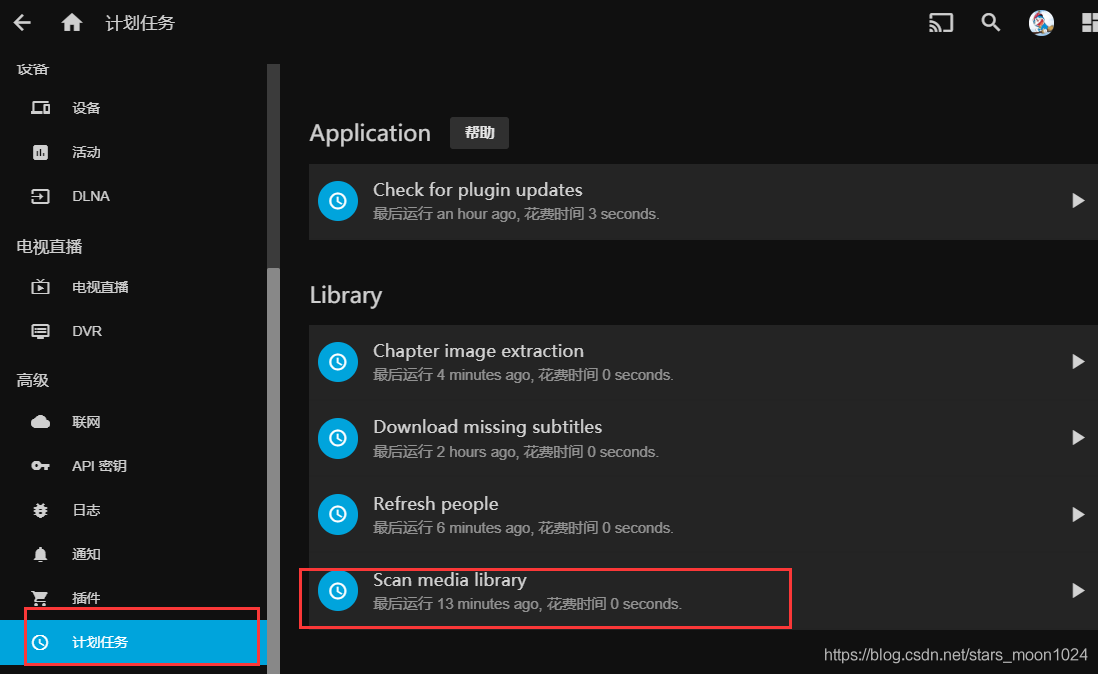

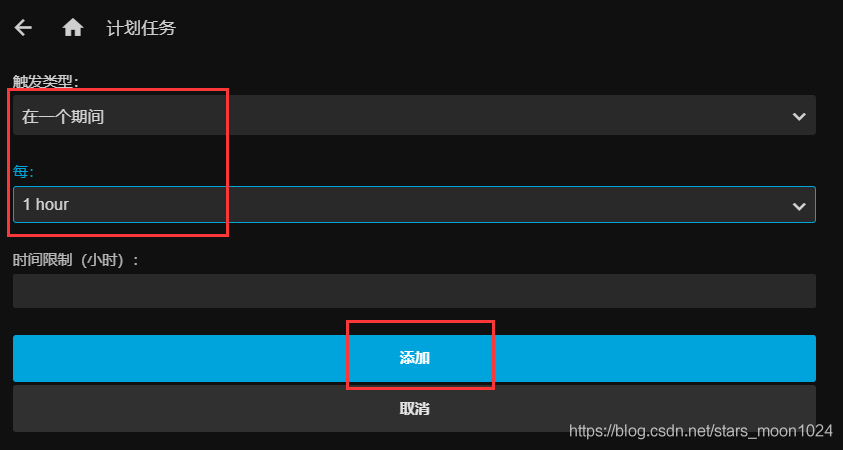

7、使用jellyfin添加媒体库

在这里,把媒体库的自动扫描调整为每个小时都扫描一次,这样可以很快的增加到媒体库。

至此,已经完成了自动从电影网下载电影,并自动扫描到媒体库,就可以不用管了,每2天自动更新。写的脚本只下载了详情页的第一页,如果想下载很多页,请把主方法中的循环打开调整数字就可以了

智能推荐

python服务器端开发面试_【网易游戏Python面试】python 服务端开发-看准网-程序员宅基地

文章浏览阅读145次。10.21终面已参加,希望能顺利通过终面拿到offer~一共三轮,电话面试+笔试+视频面试,视频面试3V110月19日投的新媒体运营的简历,HR说因为是周末,等工作日再联系我,在周一下午三点我接到了电话成功通过简历筛选和电话面试,整个电话面试的过程长,大概10分钟左右,因为前期稍微做了一些准备,所以还算对答如流,整个过程顺利,HR现场告诉我通过面试,并随即给我发了笔试题,让我准备一下,最晚三天之..._网易 python游戏服务器

MVC层次划分简述_mvc分层-程序员宅基地

文章浏览阅读6.5k次,点赞12次,收藏38次。MVC层次划分简述写在前面的一段话:首先要知道MVC和三层架构之间有什么关系:MVC:【 Model(数据模型) - View(视图) - Controller(控制器) 】三层架构:【 Presentation tier(展现层) - Application tier(应用层)+Date tier(数据访问层) 】很多人都有一个误解,认为Spring MVC的M、V、C对..._mvc分层

Flink的sink实战之三:cassandra3_flink cassandra-程序员宅基地

文章浏览阅读2.9k次。实践flink数据集sink到cassandra3_flink cassandra

使用docker安装codimd,搭建你自己的在线协作markdown编辑器_群晖 docker 搭建 codimd-程序员宅基地

文章浏览阅读7.1k次,点赞4次,收藏12次。文章目录一、前言二、codimd是什么?2.1 源于hackmd的超好用markdown编辑器2.2 codimd的作用三、安装和使用3.1 安装前需要知道的3.2 安装步骤3.2.1 创建数据库3.2.2 安装git3.2.3 安装docker3.2.4 安装docker compose3.2.5 安装codimd3.2.6 检查是否安装成功3.2.7 放行端口3.2.8 测试使用3.3 开始写..._群晖 docker 搭建 codimd

Json和ajax-程序员宅基地

文章浏览阅读335次。Json json 可以定义多种类型 var jsonObj = { "key1":123, "key2":"name", "key3":[12,"age",true], //数组 "key4":false, "key5":{ //存一个json对象 "key6":456, "key7":"number" }} json其实就是一个Object对象, 他的key值 可以看成对象的一个属性, 获取他的value值...

ssm超市账单管理系统a2e96【独家源码】 应对计算机毕业设计困难的解决方案-程序员宅基地

文章浏览阅读87次。选题背景:超市账单管理系统是一种针对超市行业的管理工具,旨在提供高效、准确、便捷的账单管理服务。随着城市化进程的加快和人们生活水平的提高,超市作为日常生活必需品的主要供应渠道之一,扮演着重要的角色。然而,传统的超市账单管理方式存在一些问题,如手工记录容易出错、数据整理繁琐、信息不透明等。因此,开发一个科技化的超市账单管理系统成为了必要之举。选题意义:首先,超市账单管理系统的开发可以提高账单管理的效率。传统的超市账单管理方式通常需要员工手动记录商品销售信息,并进行数据整理和汇总。这种方式容易出现人为错

随便推点

bookmarks_2021_9_28_拾度智能科技 att7022eu-程序员宅基地

文章浏览阅读1.7k次。书签栏通讯 s7-1200与s7-200smart通讯-工业支持中心-西门子中国IO_deviceS7-1200PROFINET通信ET 200SP 安装视频 - ID: 95886218 - Industry Support Siemens云平台接入在线文档 - 低代码开发嵌入式设备 | 物一世 WareExpress在linux下使用c语言实现MQTT通信(一.MQTT原理介绍及流程图)_qq_44041062的博客-程序员宅基地C mqtt_百度搜索开发快M_拾度智能科技 att7022eu

国家取消职称英语与计算机,全国职称英语考试取消-程序员宅基地

文章浏览阅读1.6k次。职称英语全称为全国专业技术人员职称英语等级考试,是由国家人事部组织实施的一项国家级外语考试。1.概述全国专业技术人员职称英语等级考试是由人力资源和社会保障部组织实施的一项外语考试,它根据英语在不同专业领域活动中的应用特点,结合专业技术人员掌握和应用英语的实际情况,对申报不同级别职称的专业技术人员的英语水平提出了不同的要求。该考试根据专业技术人员使用英语的实际情况,把考试的重点放在了阅读理解上面。全..._全国专业技术人员职称英语等级考试 北京 取消

where里能用max吗_网络里能找到真爱吗?-程序员宅基地

文章浏览阅读42次。恋爱指导篇 知心的小爱“真爱”是一个永不过时的话题,古代的人找对象,靠的是媒妁之言,父母定婚姻。现代的人靠的是相亲,自由恋爱,按理找一个喜欢的人结婚会很幸福,近几年反而离率更高了。古代人认识的人少,交流工具少,最多信鸽传书,信物传情。现代要认识一个人很容易了,最初是电话信息联系。前几年是qq,微信摇一摇,近两年是抖音,快手随便找一找。虽然找对象,寻伴侣更方便了,为何大部分人还是感觉更迷茫,不快乐...

刷题记录第八十天-修剪二叉搜索树-程序员宅基地

文章浏览阅读109次。【代码】刷题记录第八十天-修剪二叉搜索树。

dcm4che,WADO相关-程序员宅基地

文章浏览阅读248次。关于 dcm4che WADO WADO:Web Access to DICOM Objects dcm4che 是一个为医疗保健企业的开源应用程序和工具集合。这些应用程序已经开发了Java编程语言的性能和便携性,在JDK 1.6及更高版本支持部署。在dcm4che项目的核心是一个强大的执行DICOM标准的。该dcm4che-1.x和dcm4che-2.X DICOM Tool..._dcm4che实现wado服务

linux查看zk日志,14.1 zookeeper日志查看-程序员宅基地

文章浏览阅读2.2k次。zookeeper服务器会产生三类日志:事务日志、快照日志和log4j日志。在zookeeper默认配置文件zoo.cfg(可以修改文件名)中有一个配置项dataDir,该配置项用于配置zookeeper快照日志和事务日志的存储地址。在官方提供的默认参考配置文件zoo_sample.cfg中,只有dataDir配置项。其实在实际应用中,还可以为事务日志专门配置存储地址,配置项名称为dataLogD..._linux查看zookeeper日志