搜狗日志查询分析 (MapReduce+Hive综合实验)_搜狗搜索日志分析结果hadoop-程序员宅基地

技术标签: hive Hive Hadoop hadoop MapReduce 日志分析

前提条件:

安装好hadoop2.7.3(Linux系统下)

安装好MySQL(Windows或Linux系统下)

安装好Hive(Linux系统下)参考:Hive安装配置

题目:

从搜狗实验室下载搜索数据进行分析

下载的数据包含6个字段,数据格式说明如下:

访问时间 用户ID [查询词] 该URL在返回结果中的排名 用户点击的顺序号 用户点击的URL

注意:

1.字段分隔符:字段分隔符是个数不等的空格;

2.字段个数:有些行有6个字段,有些达不到6个字段。

问题:使用MapReduce和Hive查询出搜索结果排名为第2名,点击顺序排在第1的数据?

实验步骤:

思路:用MapReduce做数据清洗,用Hive来分析数据。

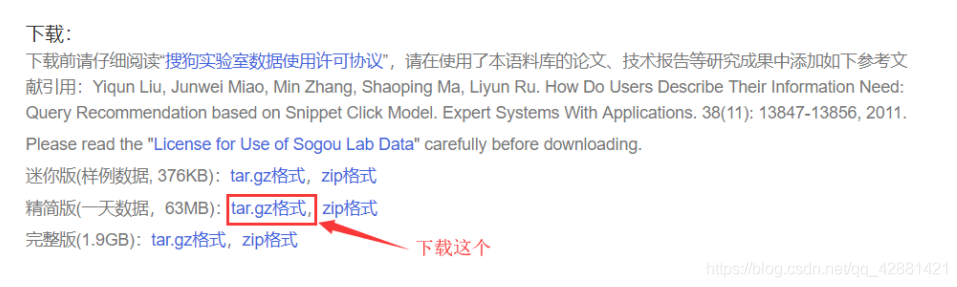

1.下载数据源

打开搜狗实验室链接

http://www.sogou.com/labs/resource/q.php

下载精简版(一天数据,63MB) tar.gz格式数据

下载后文件如下:

![]()

2.上传下载文件至HDFS

2.1将下载的文件通过WinScp工具上传到Linux系统

![]()

2.2 解压SogouQ.reduced.tar.gz并上传到HDFS

解压:

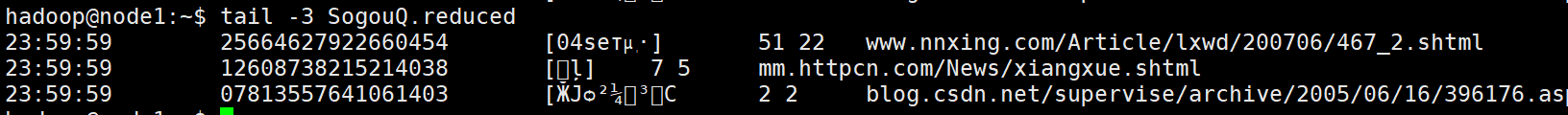

$ tar -zxvf SogouQ.reduced.tar.gz可以用tail命令查看解压文件最后3行的数据

tail -3 SogouQ.reduced查询词为中文,这里编码按UTF-8查出来是乱码,编码时指定为‘GBK’可避免乱码。数据格式如前面的说明:

访问时间 用户ID [查询词] 该URL在返回结果中的排名 用户点击的顺序号 用户点击的URL

上传至HDFS:

$ hdfs dfs -put SogouQ.reduced /

3.数据清洗

因为原始数据中有些行的字段数不为6,且原始数据的字段分隔符不是Hive表规定的逗号',',所以需要对原始数据进行数据清洗。

通过编写MapReduce程序完成数据清洗:

a.将不满足6个字段的行删除

b.将字段分隔符由不等的空格变为逗号‘,’分隔符

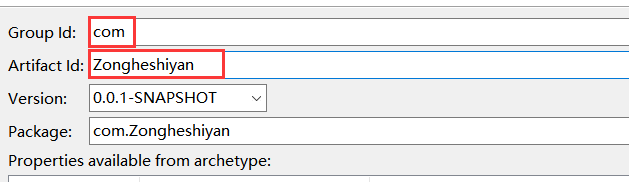

3.1 Eclipse新建Maven工程:Zongheshiyan

Group Id填写com, Artifact Id填写Zongheshiyan

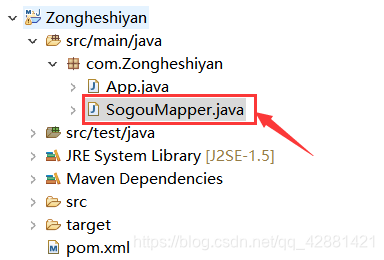

新建工程目录结构如下:

3.2 修改pom.xml文件

设置主类:在</project>一行之前添加如下语句

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>3.1.0</version>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<transformers>

<transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

<!-- main()所在的类,注意修改为包名+主类名 -->

<mainClass>com.Zongheshiyan.App</mainClass>

</transformer>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>添加依赖:在 </dependencies>一行之前添加如下语句

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.7.3</version>

</dependency>3.3 新建SogouMapper类

3.4 编写代码

SogouMapper.java

package com.Zongheshiyan;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

// k1 , v1, k2 , v2

public class SogouMapper extends Mapper<LongWritable,Text,Text,NullWritable> {

@Override

/**

* 在任务开始时,被调用一次。且只会被调用一次。

*/

protected void setup(Context context) throws IOException, InterruptedException {

super.setup(context);

}

@Override

protected void map(LongWritable k1, Text v1, Context context) throws IOException, InterruptedException {

//避免乱码

//数据格式:20111230000005 57375476989eea12893c0c3811607bcf 奇艺高清 1 1 http://www.qiyi.com/

String data = new String(v1.getBytes(),0,v1.getLength(),"GBK");

//split("\\s+") \\s+为正则表达式,意思是匹配一个或多个空白字符,包括空格、制表、换页符等。

//参考:http://www.runoob.com/java/java-regular-expressions.html

String words[] = data.split("\\s+");

//判断数据如果不等于6个字段,则退出程序

if(words.length != 6){

return;//return语句后不带返回值,作用是退出该程序的运行 https://www.cnblogs.com/paomoopt/p/3746963.html

}

//用逗号代替空白字符

String newData = data.replaceAll("\\s+",",");

//输出

context.write(new Text(newData),NullWritable.get());

}

@Override

/**

* 在任务结束时,被调用一次。且只会被调用一次。

*/

protected void cleanup(Context context) throws IOException, InterruptedException {

super.cleanup(context);

}

}

App.java

package com.Zongheshiyan;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

/**

* 数据清洗器 主类

*

*/

public class App

{

public static void main( String[] args ) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf);

job.setJarByClass(App.class);

//指定map输出

job.setMapperClass(SogouMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(NullWritable.class);

//指定reduce的输出

job.setOutputKeyClass(Text.class);

job.setMapOutputValueClass(NullWritable.class);

//指定输入、输出

FileInputFormat.setInputPaths(job,new Path(args[0]));

FileOutputFormat.setOutputPath(job,new Path(args[1]));

//提交job,等待结束

job.waitForCompletion(true);

}

}

3.5 打包工程:mvn clean package

3.6上传到Linux: WinScp工具

3.7 运行jar包

在运行jar包之前,确保开启了hadoop所有进程

start-all.sh同时也把mr历史服务器进程打开

mr-jobhistory-daemon.sh start historyserver运行jar包:

hadoop jar Zongheshiyan-0.0.1-SNAPSHOT.jar /SogouQ.reduced /out/Oneday![]()

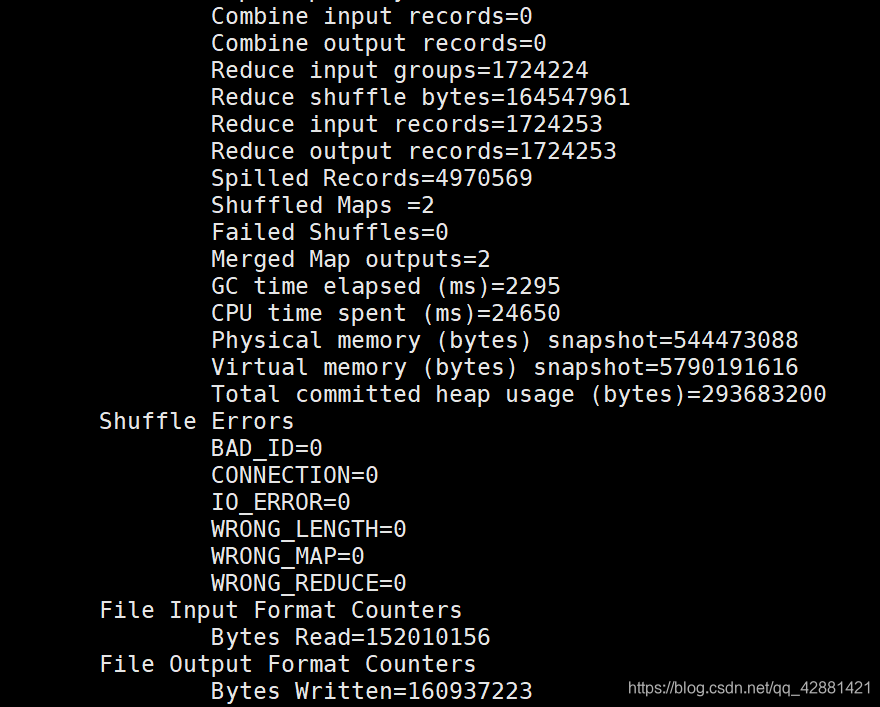

机器配置不同,执行时间也不同(执行时间约3分钟左右)。 看到输出如下图所示为执行成功。

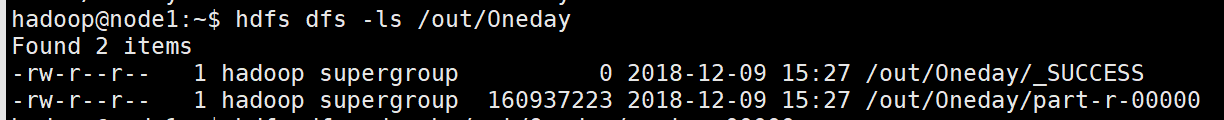

查看输出结果

hdfs dfs -ls /out/Oneday

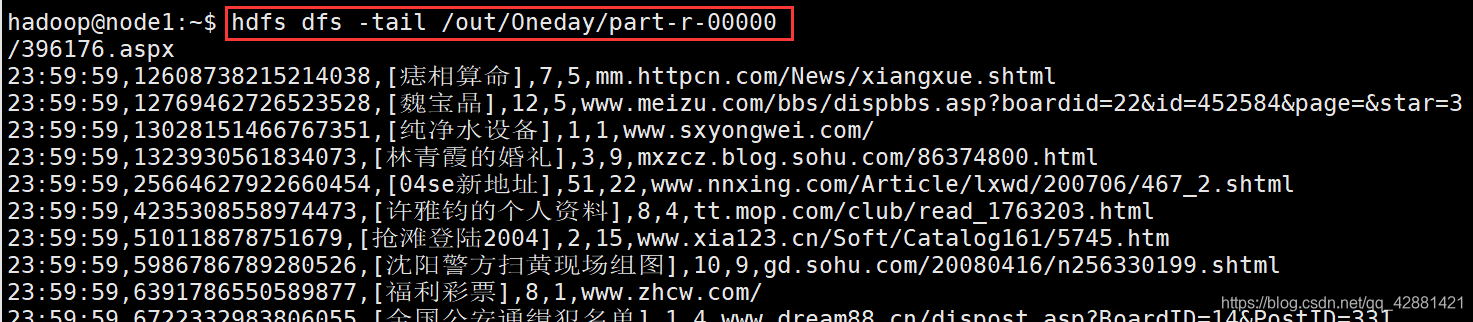

查看输出文件最后10行数据:

hdfs dfs -tail /out/Oneday/part-r-00000

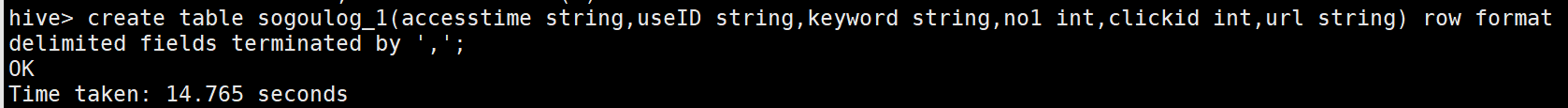

4.创建hive表

进入hive命令行

hive创建hive表

create table sogoulog_1(accesstime string,useID string,keyword string,no1 int,clickid int,url string) row format delimited fields terminated by ',';

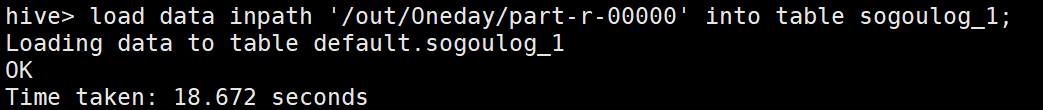

5.将MapReduce清洗后的数据导入Hive sogoulog_1表中

load data inpath '/out/Oneday/part-r-00000' into table sogoulog_1;

6.使用SQL查询满足条件的数据(只显示前10条)

select * from sogoulog_1 where no1=2 and clickid=1 limit 10;

其实,还可以对数据做一些探索,例如:

查看 sogoulog_1表结构

hive> describe sogoulog_1;

OK

accesstime string

useid string

keyword string

no1 int

clickid int

url string

Time taken: 0.411 seconds, Fetched: 6 row(s)

一天内,一共搜索关键词的个数

hive> select count(keyword) from sogoulog_1;

1724253

第一次点击的次数来看,排名越靠前,点击次数越多

hive> select count(keyword) from sogoulog_1 where no1=1 and clickid=1;

279492

hive> select count(keyword) from sogoulog_1 where no1=2 and clickid=1;

99224

hive> select count(keyword) from sogoulog_1 where no1=3 and clickid=1;

50782

从排名第一URL来看,点击顺序越小越多(首先被点到的可能性就越大)。

hive> select count(keyword) from sogoulog_1 where no1=1 and clickid=1;

279492

hive> select count(keyword) from sogoulog_1 where no1=1 and clickid=2;

79721

hive> select count(keyword) from sogoulog_1 where no1=1 and clickid=3;

39726

小结:

MapReduce对原始数据进行清洗,是本实验的难点,要结合注释看懂代码(数据清洗)。

hive对数据进行数据分析,找到隐含在数据中的规律/价值(数据挖掘)。

还可以做的是数据可视化等。

完成! enjoy it!

智能推荐

Docker 快速上手学习入门教程_docker菜鸟教程-程序员宅基地

文章浏览阅读2.5w次,点赞6次,收藏50次。官方解释是,docker 容器是机器上的沙盒进程,它与主机上的所有其他进程隔离。所以容器只是操作系统中被隔离开来的一个进程,所谓的容器化,其实也只是对操作系统进行欺骗的一种语法糖。_docker菜鸟教程

电脑技巧:Windows系统原版纯净软件必备的两个网站_msdn我告诉你-程序员宅基地

文章浏览阅读5.7k次,点赞3次,收藏14次。该如何避免的,今天小编给大家推荐两个下载Windows系统官方软件的资源网站,可以杜绝软件捆绑等行为。该站提供了丰富的Windows官方技术资源,比较重要的有MSDN技术资源文档库、官方工具和资源、应用程序、开发人员工具(Visual Studio 、SQLServer等等)、系统镜像、设计人员工具等。总的来说,这两个都是非常优秀的Windows系统镜像资源站,提供了丰富的Windows系统镜像资源,并且保证了资源的纯净和安全性,有需要的朋友可以去了解一下。这个非常实用的资源网站的创建者是国内的一个网友。_msdn我告诉你

vue2封装对话框el-dialog组件_<el-dialog 封装成组件 vue2-程序员宅基地

文章浏览阅读1.2k次。vue2封装对话框el-dialog组件_

MFC 文本框换行_c++ mfc同一框内输入二行怎么换行-程序员宅基地

文章浏览阅读4.7k次,点赞5次,收藏6次。MFC 文本框换行 标签: it mfc 文本框1.将Multiline属性设置为True2.换行是使用"\r\n" (宽字符串为L"\r\n")3.如果需要编辑并且按Enter键换行,还要将 Want Return 设置为 True4.如果需要垂直滚动条的话将Vertical Scroll属性设置为True,需要水平滚动条的话将Horizontal Scroll属性设_c++ mfc同一框内输入二行怎么换行

redis-desktop-manager无法连接redis-server的解决方法_redis-server doesn't support auth command or ismis-程序员宅基地

文章浏览阅读832次。检查Linux是否是否开启所需端口,默认为6379,若未打开,将其开启:以root用户执行iptables -I INPUT -p tcp --dport 6379 -j ACCEPT如果还是未能解决,修改redis.conf,修改主机地址:bind 192.168.85.**;然后使用该配置文件,重新启动Redis服务./redis-server redis.conf..._redis-server doesn't support auth command or ismisconfigured. try

实验四 数据选择器及其应用-程序员宅基地

文章浏览阅读4.9k次。济大数电实验报告_数据选择器及其应用

随便推点

灰色预测模型matlab_MATLAB实战|基于灰色预测河南省社会消费品零售总额预测-程序员宅基地

文章浏览阅读236次。1研究内容消费在生产中占据十分重要的地位,是生产的最终目的和动力,是保持省内经济稳定快速发展的核心要素。预测河南省社会消费品零售总额,是进行宏观经济调控和消费体制改变创新的基础,是河南省内人民对美好的全面和谐社会的追求的要求,保持河南省经济稳定和可持续发展具有重要意义。本文建立灰色预测模型,利用MATLAB软件,预测出2019年~2023年河南省社会消费品零售总额预测值分别为21881...._灰色预测模型用什么软件

log4qt-程序员宅基地

文章浏览阅读1.2k次。12.4-在Qt中使用Log4Qt输出Log文件,看这一篇就足够了一、为啥要使用第三方Log库,而不用平台自带的Log库二、Log4j系列库的功能介绍与基本概念三、Log4Qt库的基本介绍四、将Log4qt组装成为一个单独模块五、使用配置文件的方式配置Log4Qt六、使用代码的方式配置Log4Qt七、在Qt工程中引入Log4Qt库模块的方法八、获取示例中的源代码一、为啥要使用第三方Log库,而不用平台自带的Log库首先要说明的是,在平时开发和调试中开发平台自带的“打印输出”已经足够了。但_log4qt

100种思维模型之全局观思维模型-67_计算机中对于全局观的-程序员宅基地

文章浏览阅读786次。全局观思维模型,一个教我们由点到线,由线到面,再由面到体,不断的放大格局去思考问题的思维模型。_计算机中对于全局观的

线程间控制之CountDownLatch和CyclicBarrier使用介绍_countdownluach于cyclicbarrier的用法-程序员宅基地

文章浏览阅读330次。一、CountDownLatch介绍CountDownLatch采用减法计算;是一个同步辅助工具类和CyclicBarrier类功能类似,允许一个或多个线程等待,直到在其他线程中执行的一组操作完成。二、CountDownLatch俩种应用场景: 场景一:所有线程在等待开始信号(startSignal.await()),主流程发出开始信号通知,既执行startSignal.countDown()方法后;所有线程才开始执行;每个线程执行完发出做完信号,既执行do..._countdownluach于cyclicbarrier的用法

自动化监控系统Prometheus&Grafana_-自动化监控系统prometheus&grafana实战-程序员宅基地

文章浏览阅读508次。Prometheus 算是一个全能型选手,原生支持容器监控,当然监控传统应用也不是吃干饭的,所以就是容器和非容器他都支持,所有的监控系统都具备这个流程,_-自动化监控系统prometheus&grafana实战

React 组件封装之 Search 搜索_react search-程序员宅基地

文章浏览阅读4.7k次。输入关键字,可以通过键盘的搜索按钮完成搜索功能。_react search