Grafana监控系统之Prometheus+Grafana监控系统搭建_granf监控-程序员宅基地

技术标签: 监控系统 java 可视化 # Linux 学习汇总 Prometheus Grafana

Grafana监控系统之Prometheus+Grafana监控系统搭建

本文章内容较长,可通过右上角点击目录快速定位想看的内容 => =>

一. 概述

1.1 Grafana介绍

Grafana是一个跨平台的开源的度量分析和可视化工具,可以通过将采集的数据查询然后可视化的展示,并及时通知。它主要有以下六大特点:

-

展示方式:快速灵活的客户端图表,面板插件有许多不同方式的可视化指标和日志,官方库中具有丰富的仪表盘插件,比如热图、折线图、图表等多种展示方式;

-

数据源:Graphite,InfluxDB,OpenTSDB,Prometheus,Elasticsearch,CloudWatch和KairosDB等;

-

通知提醒:以可视方式定义最重要指标的警报规则,Grafana将不断计算并发送通知,在数据达到阈值时通过Slack、PagerDuty等获得通知;

-

混合展示:在同一图表中混合使用不同的数据源,可以基于每个查询指定数据源,甚至自定义数据源;

-

注释:使用来自不同数据源的丰富事件注释图表,将鼠标悬停在事件上会显示完整的事件元数据和标记;

-

过滤器:Ad-hoc过滤器允许动态创建新的键/值过滤器,这些过滤器会自动应用于使用该数据源的所有查询。

简单来讲,它是一个多用途的监控工具,同时通过邮件等方式进行有效的预警通知,丰富的直观的可视化界面,多种数据源配置是其优点所在;

1.2 Prometheus对比Zabbix

-

和Zabbix类似,Prometheus也是一个近年比较火的开源监控框架,和Zabbix不同之处在于Prometheus相对更灵活点,模块间比较解耦,比如告警模块、代理模块等等都可以选择性配置。服务端和客户端都是开箱即用,不需要进行安装。zabbix则是一套安装把所有东西都弄好,很庞大也很繁杂。

-

zabbix的客户端agent可以比较方便的通过脚本来读取机器内数据库、日志等文件来做上报。而Prometheus的上报客户端则分为不同语言的SDK和不同用途的exporter两种,比如如果你要监控机器状态、mysql性能等,有大量已经成熟的exporter来直接开箱使用,通过http通信来对服务端提供信息上报(server去pull信息);而如果你想要监控自己的业务状态,那么针对各种语言都有官方或其他人写好的sdk供你使用,都比较方便,不需要先把数据存入数据库或日志再供zabbix-agent采集。

-

zabbix的客户端更多是只做上报的事情,push模式。而Prometheus则是客户端本地也会存储监控数据,服务端定时来拉取想要的数据。

-

界面来说zabbix比较陈旧,而prometheus比较新且非常简洁,简洁到只能算一个测试和配置平台。要想获得良好的监控体验,搭配Grafana还是二者的必走之路。

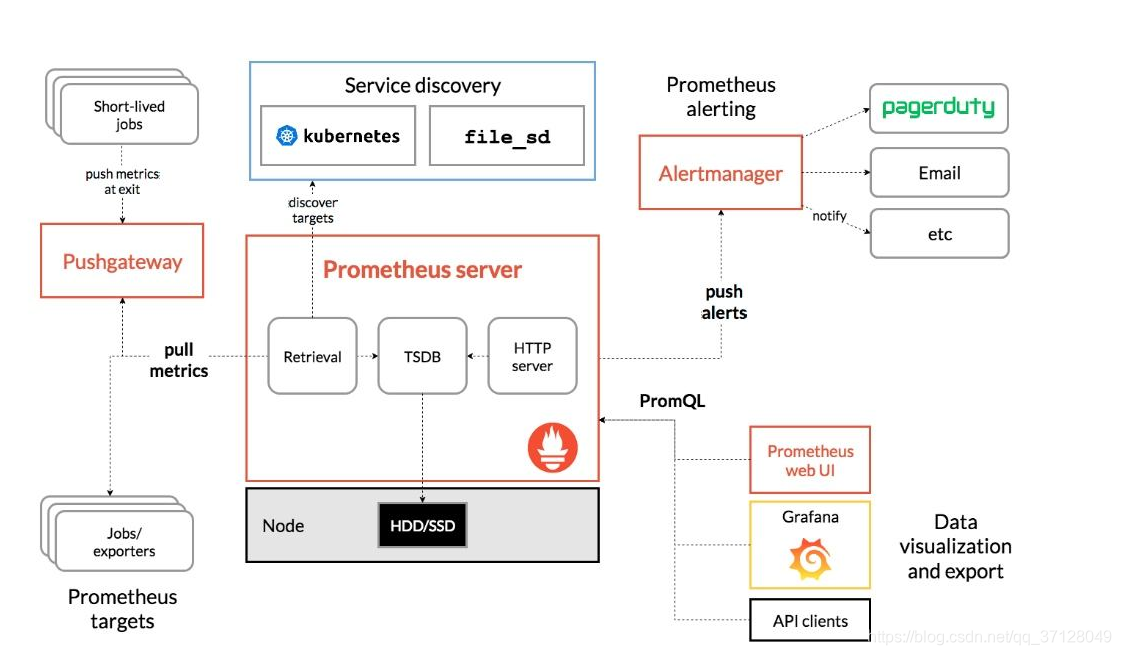

1.3 Grafana结构图

1.4 通俗讲

- Prometheus作为一个中间点,而Grafana作为可视化展示,后面的exporter作为监控,exporter将需要获取的数据获取并连接到Prometheus,而Prometheus连接到Grafana,直观展示被监控者状态;

二. Grafana监控系统之Prometheus+Grafana监控系统搭建

2.1 安装Prometheus

- 下载并解压

wget https://github.com/prometheus/prometheus/releases/download/v2.7.2/prometheus-2.7.2.linux-amd64.tar.gztar xvfz prometheus-2.7.2.linux-amd64.tar.gz - 运行Prometheus server

cd prometheus-2.7.2.linux-amd64./prometheus --config.file=prometheus.yml - 配置Prometheus

- 在Prometheus.yml中有配置文件,我们可以对其进行配置,当然第一次安装也可以不管;

$ cat prometheus.yml # my global config global: scrape_interval: 15s # Set the scrape interval to every 15 seconds. Default is every 1 minute. evaluation_interval: 15s # Evaluate rules every 15 seconds. The default is every 1 minute. # scrape_timeout is set to the global default (10s). # Alertmanager configuration alerting: alertmanagers: - static_configs: - targets: # - alertmanager:9093 # Load rules once and periodically evaluate them according to the global 'evaluation_interval'. rule_files: # - "first_rules.yml" # - "second_rules.yml" # A scrape configuration containing exactly one endpoint to scrape: # Here it's Prometheus itself. scrape_configs: # The job name is added as a label `job=<job_name>` to any timeseries scraped from this config. - job_name: 'prometheus' # metrics_path defaults to '/metrics' # scheme defaults to 'http'. static_configs: - targets: ['localhost:9090']

其大致可分为四部分:

- global:全局配置,其中scrape_interval表示抓取一次数据的间隔时间,evaluation_interval表示进行告警规则检测的间隔时间;

- alerting:告警管理器(Alertmanager)的配置,目前还没有安装Alertmanager;

- rule_files:告警规则有哪些;

- scrape_configs:抓取监控信息的目标。一个job_name就是一个目标,其targets就是采集信息的IP和端口。这里默认监控了Prometheus自己,可以通过修改这里来修改Prometheus的监控端口。Prometheus的每个exporter都会是一个目标,它们可以上报不同的监控信息,比如机器状态,或者mysql性能等等,不同语言sdk也会是一个目标,它们会上报你自定义的业务监控信息。

- 访问prometheus

- 输入: “ip地址”+":9090" 在浏览器中进行访问,如果出现可视化界面说明成功;

示例: 186.163.15.42:9090 直接在自己电脑中访问

如果访问不了,请检查防火墙是否开启9090端口

2.2 添加机器状态监控(监控服务器CPU,硬盘,网络等状态)

-

下载且解压并运行

// 下载最新版本,可以在github的release中对最新版本右键获取下载链接 wget https://github.com/prometheus/node_exporter/releases/download/v0.17.0/node_exporter-0.17.0.linux-amd64.tar.gz -

解压

tar xvfz node_exporter-0.17.0.linux-amd64.tar.gz -

进入解压出的目录

cd node_exporter-0.17.0.linux-amd64 -

运行监控采集服务

./node_exporter -

监听9100端口

- 本Centos中访问:

curl http://localhost:9100/metrics - 电脑浏览器中访问:

ip地址:9100

如果访问有内容显示则成功

启动服务的时候可使用nohup后台启动,如果是直接图中所示内容启动则重开连接

- 去Prometheus的配置文件中加上这个exporter的地址

- 先回到根目录

cd ~ - 本Centos中访问:

-

进入prometheus

cd prometheus-2.7.2.linux-amd64/ -

编辑配置文件prometheus.yml

vim prometheus.yml

没有vim可以下载或者使用vi也可以

- 添加target:

scrape_configs: - job_name: 'prometheus' static_configs: - targets: ['localhost:9090'] - job_name: 'server' static_configs: - targets: ['localhost:9100']

2.3 安装Grafana

- 下载并解压Grafana

wget https://dl.grafana.com/oss/release/grafana-6.0.0.linux-amd64.tar.gztar -zxvf grafana-6.0.0.linux-amd64.tar.gz

这个页面给出的是最新版本的安装命令,右上角可以选择切换其他版本的安装命令。解压后会出现 grafana-6.0.0 目录,进入该目录,然后就可以运行Grafana了;

-

安装插件

- 进入Grafana服务器的该Grafana的lib目录下,然后输入以下命令更新插件:

./grafana-cli plugins install grafana-piechart-panel

- 进入Grafana服务器的该Grafana的lib目录下,然后输入以下命令更新插件:

-

进入Grafana目录

cd grafana-6.0.0- 启动Grafana。

./bin/grafana-server web -

在Grafana展示监控信息

-

安装并启动Grafana后,浏览器输入 IP:3000 来访问Grafana,管理员账号密码默认是admin/admin。首次登陆会让你修改管理员密码,然后就可以登录查看了。

-

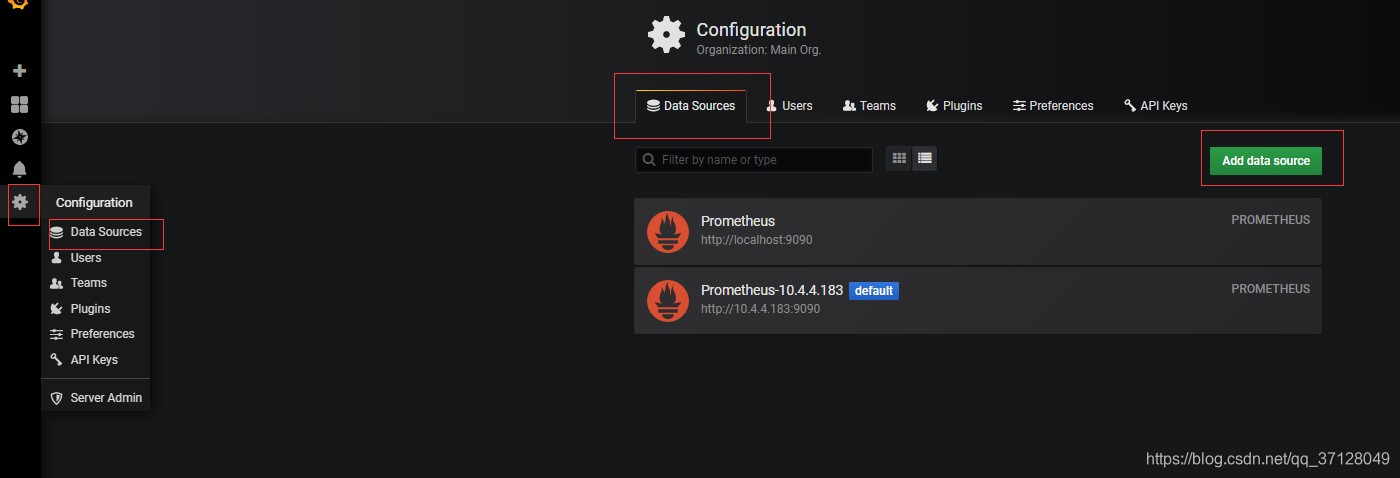

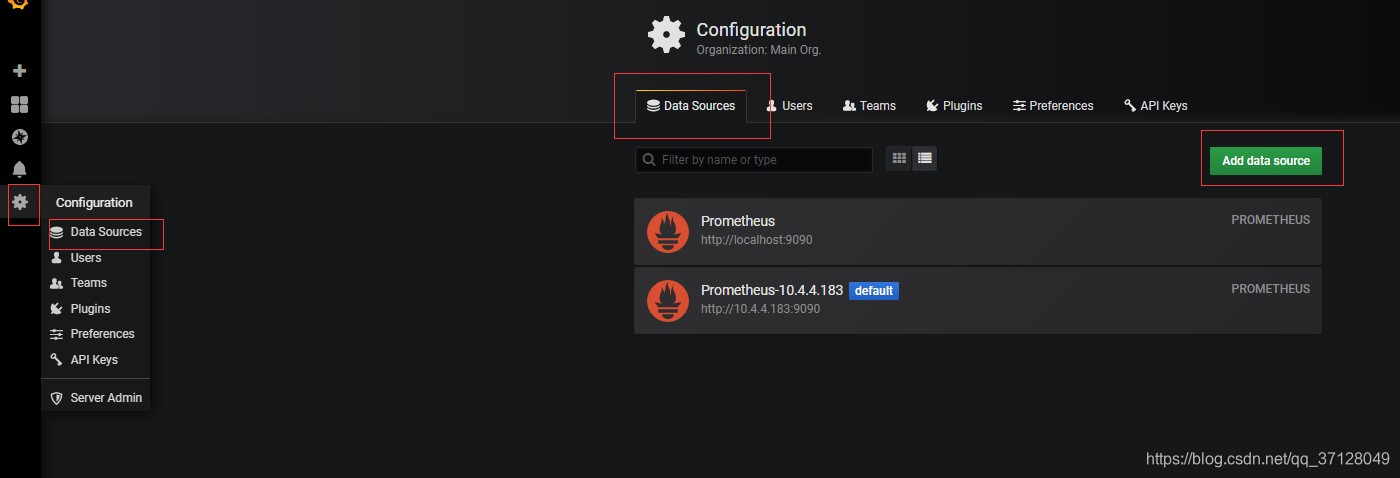

添加数据源

-

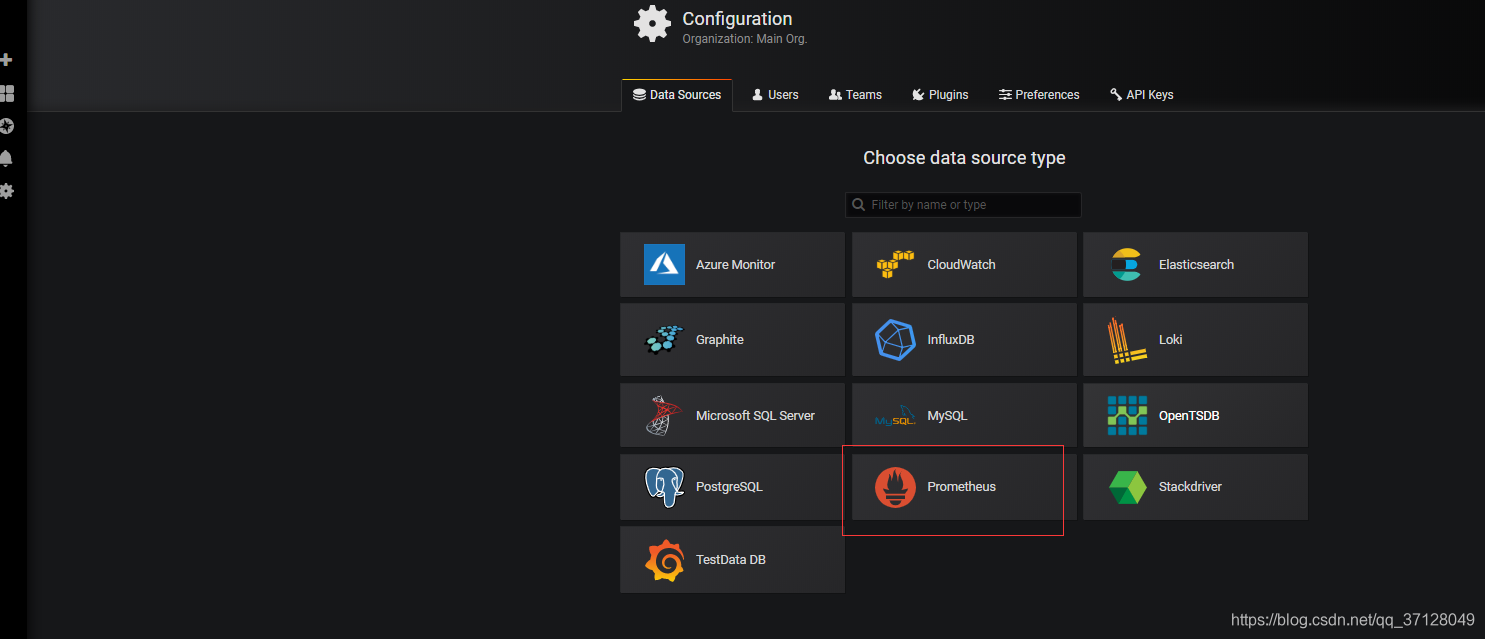

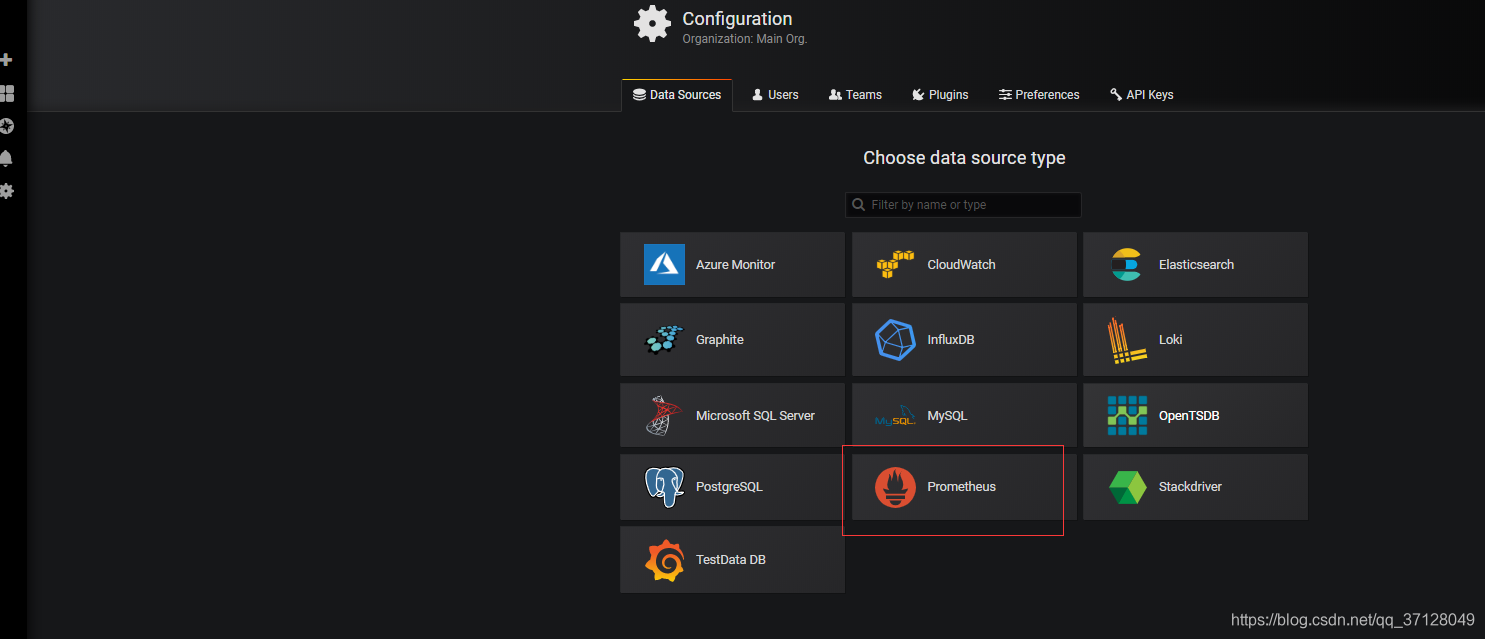

选择Prometheus

-

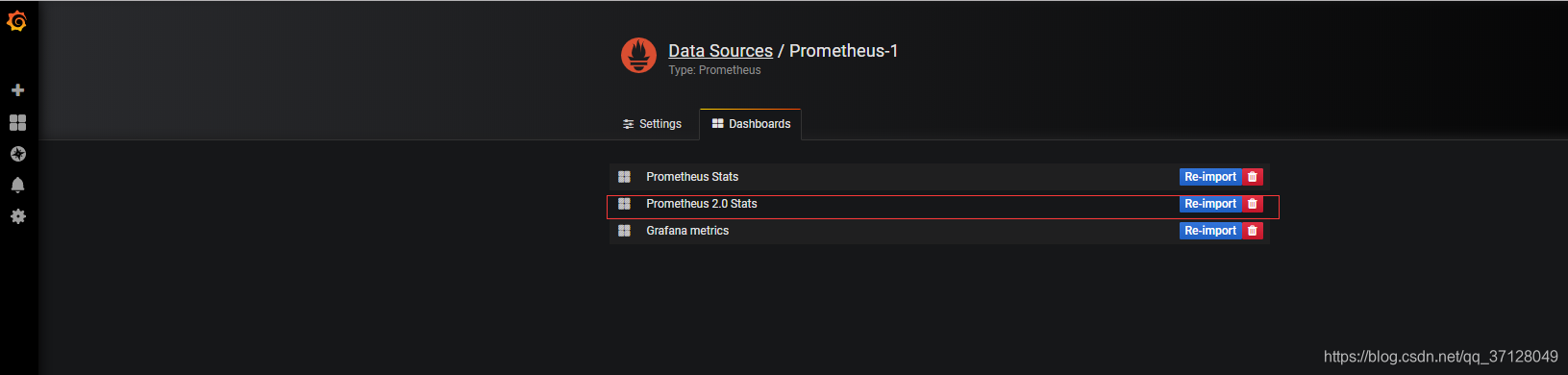

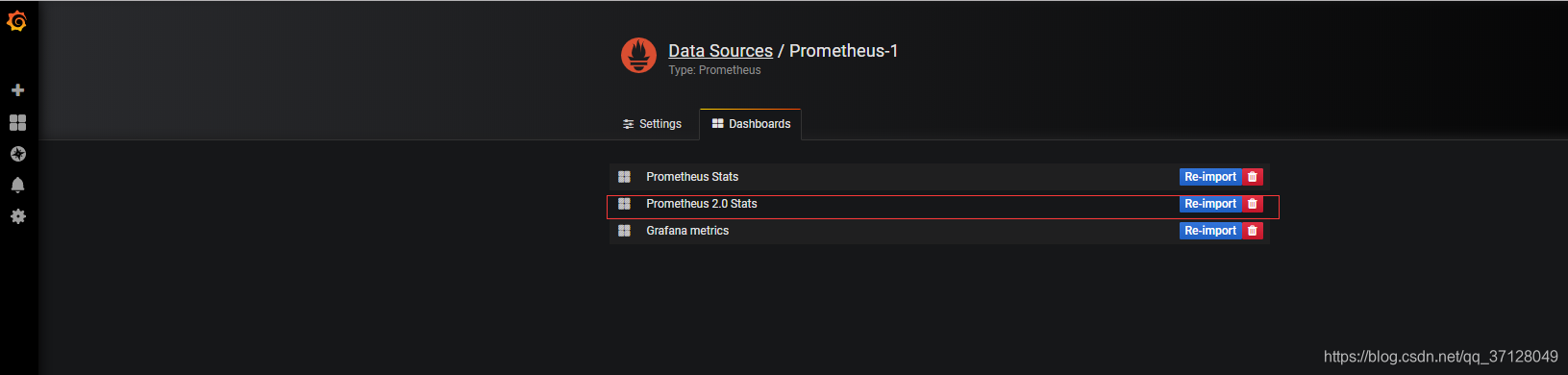

先输入名称,然后填入http://ip+9090然后直接点Save&Test,成功后则直接点击Dashboards选择展示面板

-

点击导入,可一个也可以全部导入

-

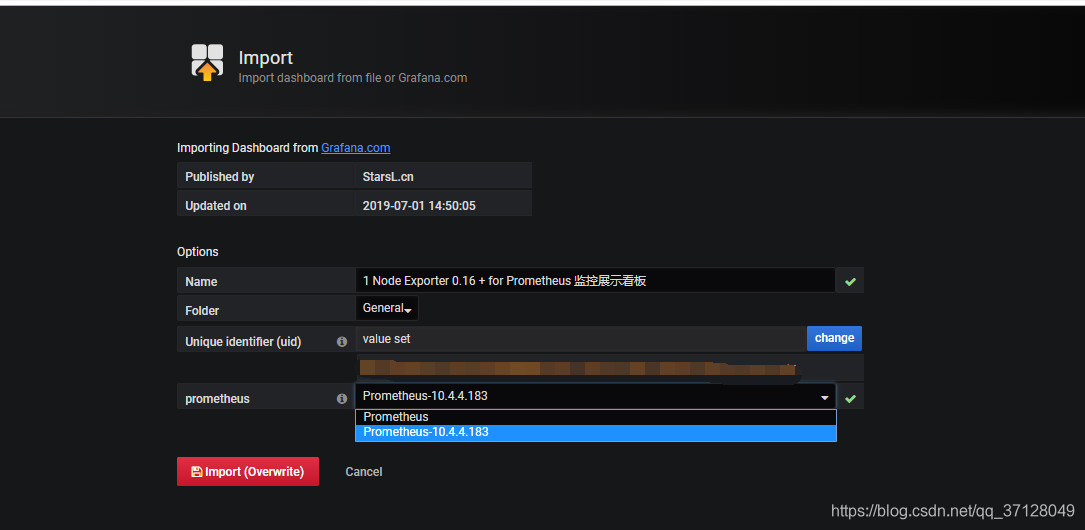

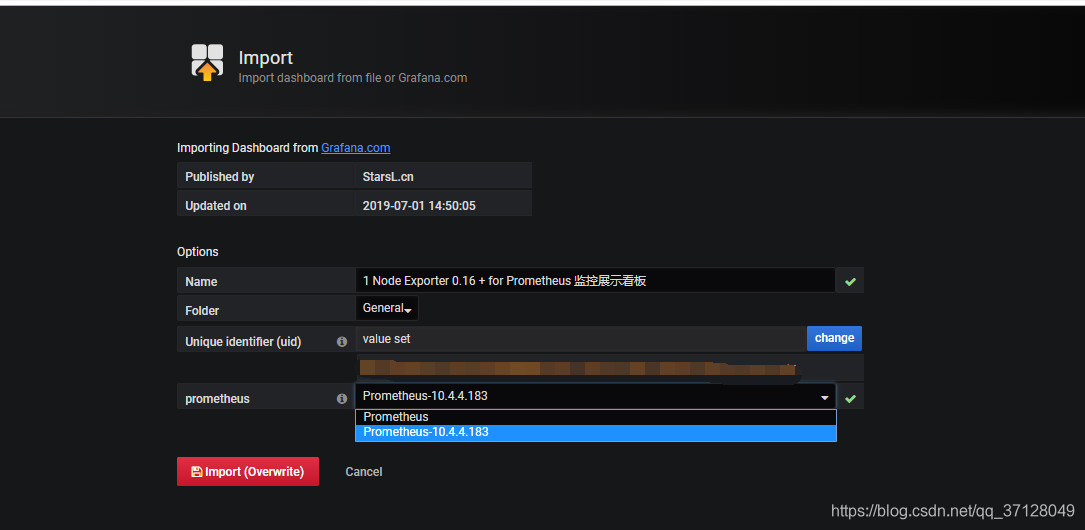

选择左侧边栏的 + 号,点击Imput, 在Grafana.com Dashboard中输入: 8919

也可以自己选择官方展示面板,链接: https://grafana.com/dashboards

- 输入号码后点击确定,然后再prometheus选择对应的Prometheus,点击Import即可

-

-

查看效果

-

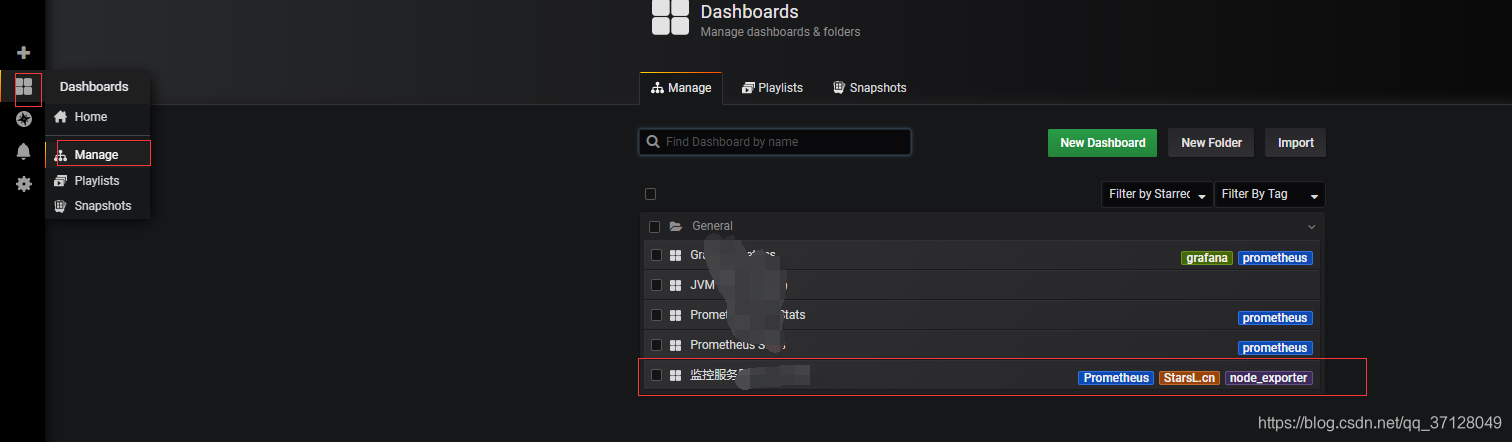

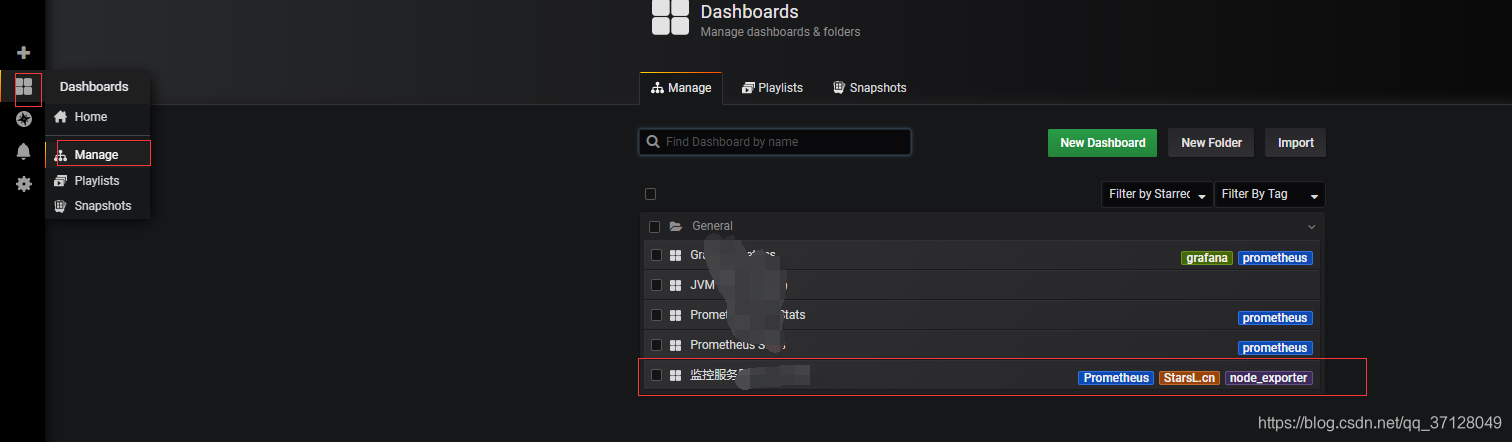

左边侧栏选择方块,点击Manage,然后点击刚刚创建的,即可成功展示!

-

展示效果如图所示:

-

三. Grafana监控系统之搭建其他服务器监控系统

3.1 前述

-

这次的教程是配置其他服务器的监控系统,所以假设上面的已经做好了

-

监控系统的Prometheus类似于一个注册中心,我们可以只需要配置一个Prometheus,而在其他服务器,只需要安装node_exporter,它们的数据流转就是通过exporter采集数据信息,然后告诉prometheus它的位置;而Prometheus则存储exporter的信息供Grafana询问;Grafana则负责信息的展示;所以可以只配置一个Prometheus,而其他服务器或者本机的服务器的exporter只需要在这一个Promethes中给出它的job_name,targets地址等信息即可;

-

这里介绍了又重新下载了一个Prometheus的方式,不下载的话可直接跳过从教程: 3.5 添加机器状态监控 开始

3.2 安装Prometheus

- 连接需要被安装的服务器,安装Prometheus:

wget https://github.com/prometheus/prometheus/releases/download/v2.7.2/prometheus-2.7.2.linux-amd64.tar.gztar xvfz prometheus-2.7.2.linux-amd64.tar.gz

3.3 启动Prometheus

- 下载最新版本,可以在github的release中对最新版本右键获取下载链接

wget https://github.com/prometheus/node_exporter/releases/download/v0.17.0/node_exporter-0.17.0.linux-amd64.tar.gz - 解压

tar xvfz node_exporter-0.17.0.linux-amd64.tar.gz - 进入解压出的目录

cd node_exporter-0.17.0.linux-amd64 - 运行监控采集服务

./node_exporter

3.4 配置Prometheus:

$ cat prometheus.yml

# my global config

global:

scrape_interval: 15s # Set the scrape interval to every 15 seconds. Default is every 1 minute.

evaluation_interval: 15s # Evaluate rules every 15 seconds. The default is every 1 minute.

# scrape_timeout is set to the global default (10s).

# Alertmanager configuration

alerting:

alertmanagers:

- static_configs:

- targets:

# - alertmanager:9093

# Load rules once and periodically evaluate them according to the global 'evaluation_interval'.

rule_files:

# - "first_rules.yml"

# - "second_rules.yml"

# A scrape configuration containing exactly one endpoint to scrape:

# Here it's Prometheus itself.

scrape_configs:

# The job name is added as a label `job=<job_name>` to any timeseries scraped from this config.

- job_name: 'prometheus'

# metrics_path defaults to '/metrics'

# scheme defaults to 'http'.

static_configs:

- targets: ['localhost:9090']

如无其他特殊需求可不做改变;

3.5 添加机器状态监控

~~~java

// 下载最新版本,可以在github的release中对最新版本右键获取下载链接

wget https://github.com/prometheus/node_exporter/releases/download/v0.17.0/node_exporter-0.17.0.linux-amd64.tar.gz

~~~

- 解压

tar xvfz node_exporter-0.17.0.linux-amd64.tar.gz - 进入解压出的目录

cd node_exporter-0.17.0.linux-amd64 - 运行监控采集服务

./node_exporter

可使用后台运行进程命令启动也可以;访问:http://ip:9100/metrics即可验证,如果有对应界面则配置成功

3.6 配置Prometheus.yml文件

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

- job_name: 'server'

static_configs:

- targets: ['localhost:9100']

如果prometheus不在本服务器,则将server下的targets中的localhost改为对应的ip地址;

重新启动一下

3.7 配置Grafana

- 进入Grafana服务器的该Grafana的lib目录下,然后输入以下命令更新插件:

./grafana-cli plugins install grafana-piechart-panel

更新插件后重新启动服务

3.8 配置可视化界面

- 添加数据源

- 选择Prometheus

- 先输入名称,然后填入http://ip+9090然后直接点Save&Test,成功后则直接点击Dashboards选择展示面板

- 点击导入,可一个也可以全部导入

- 选择左侧边栏的 + 号,点击Imput, 在Grafana.com Dashboard中输入: 8919

也可以自己选择官方展示面板,链接: https://grafana.com/dashboards

- 输入号码后点击确定,然后再prometheus选择对应的Prometheus,点击Import即可

3.9 查看效果

-

左边侧栏选择方块,点击Manage,然后点击刚刚创建的,即可成功展示!

-

展示效果如图所示:

注意:如果需要监控其他服务器,则只需要在其他服务器安装 node_exporter 即可,将其对应的ip地址,端口号等信息配置到已有的Prometheus的Prometheus.yml内即可;格式参照其他,job_name不能命名成一样的,可改成其他名称;Grafana添加数据源和注册仪表盘都是一致的;

四. Grafana监控系统之邮件报警

4.1 Grafana服务器配置

- 关闭服务

ctrl+c

如果是后台启动的服务,则用相关的命令关闭grafana web

如果grafana监控系统没有开启,则无需关闭;

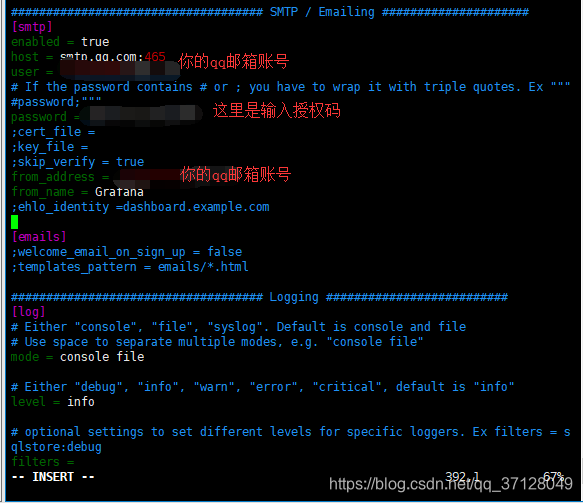

- 进入grafana目录

cd grafana-6.0.0 - 编辑配置文件conf

vim defaults.ini

没有vim直接 yum install vim 即可,使用vi 也可以进行编辑

smtp.qq.com:465是针对qq邮箱的,其他的邮箱的服务器不同,请做对应的改变,直接百度即可;

- 编辑完退出:

ESC+:wq+Enter - 返回上一级

cd .. - 启动服务

./bin/grafana-server web

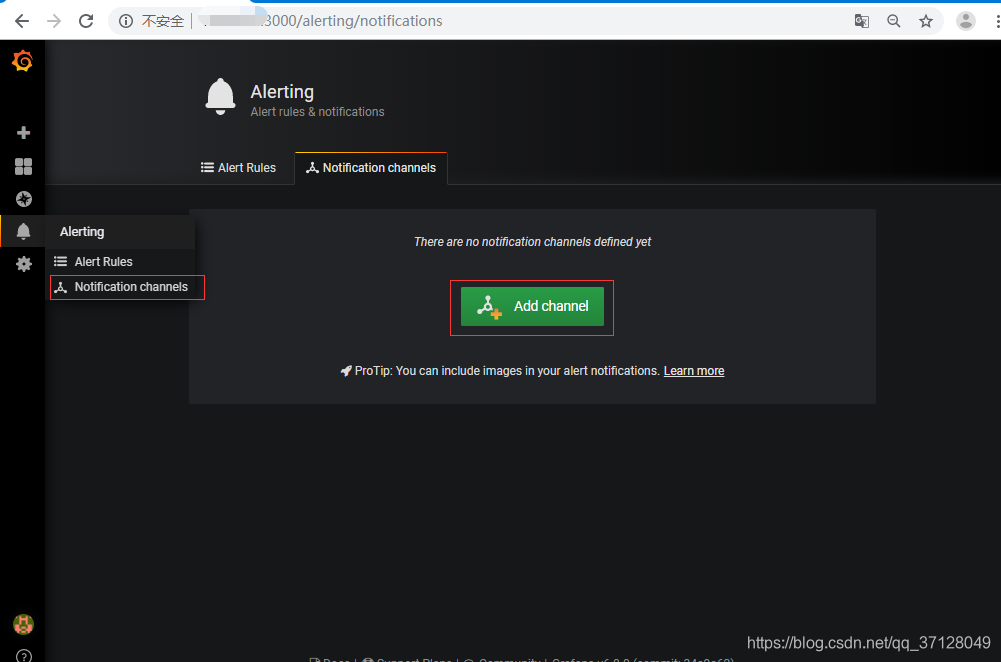

4.2 Grafana 可视化界面配置

- 添加

- 输入具体警告内容

如果成功就能接收到邮件,否则查看服务器内配置是否正确;

4.3 邮件报警总结

- 此功能可以具体对某些仪表盘的数据设立阀值,如果超过此值则触发报警,具体的应用具体分析,后面补充;

五. Grafana监控系统之搭建MySQL监控系统

5.1 步骤概述概述

- 下载安装Mysql并配置账号密码

- 导入sql文件

- 安装mysqld_exporter

- 对mysqld_exporter进行操作

- 运行mysql_exporter

- 加入Prometheus.yml配置

- 配置可视化界面

5.2 下载安装Mysql

-

如果是对已有的mysql进行操作,请忽略此步骤;

-

下载mysql的repo源:

wget http://repo.mysql.com/mysql-community-release-el7-5.noarch.rpm -

安装mysql-community-release-el7-5.noarch.rpm包:

rpm -ivh mysql-community-release-el7-5.noarch.rpm -

安装mysql:

yum install mysql-server -y -

修改权限,否则会报错:

chown -R root:root /var/lib/mysql -

重启mysql服务:

service mysqld restart -

登录并重置密码:

## 直接回车进入mysql控制台 mysql -u root mysql > use mysql; mysql > update user set password=password('123456') where user='root'; mysql > exit;

5.3 导入sql文件

- 下载my2.sql

https://codeload.github.com/john1337/my2Collector/zip/master - 解压文件后将此文件夹内的sql文件放入要监控的Mysql服务器中

- 使用命令登录mysql

mysql -u用户名 -p密码示例: mysql -uroot -proot - 使用命令导入sql文件

source /root/my2.sql

后面的是具体地址,如果位置不对则相应变化

- 当出现一系列执行成功,则说明完成;

5.4 对mysqld_exporter进行操作

- 先下载并解压:

https://github.com/prometheus/mysqld_exporter/releases/download/v0.10.0/mysqld_exporter-0.10.0.linux-amd64.tar.gztar -xvf mysqld_exporter-0.10.0.linux-amd64.tar.gz - 创建.my.cnf 文件

vim vi.my.cnf - 创建效果如下:

[client] user=root password=root

账号密码只要连接得上mysql即可,也可单独为其分配账号;

- 运行mysql_exporter

./mysqld_exporter -config.my-cnf=".my.cnf" &

5.5 加入Prometheus.yml配置

- job_name: mysql

static_configs:

- targets: ['mysql的ip地址:9104']

这里9104不要改动,配好后保存重启Prometheus,然后点击Status->Targets,如果发现mysql的State为Up 状态,则说明已经配置好了

如果没有配置好,则可以注意一下是否mysql开启了远程访问,一般新安装的msyql都是仅本机可访问;开启远程访问可百度;

5.6 配置可视化界面

- 先点击小齿轮添加DataSource,然后点击Mysql,输入对应的ip+端口号,以及账号密码等信息,点击Save&Test进行测试,如果反馈成功则说明配置成功

- 点击+ 图标,然后选择Import ,可选择官方文档中的仪表盘,这里我使用的是: 7991

输入7991点Load可自动加载

- 官方地址: https://grafana.com/dashboards

- 加载后配置相关的名称地址,以及加载的数据源等信息,点击添加后即可在 小方块 图标的Manage下展示;

- 效果图如下:

六. Grafana监控系统之开放API

6.1 概述

- 在我们使用server类型的访问模式中,访问数据通常有两种形式;一种是直接使用用户登录,获取到的Cookie进行验证;一种是通过 API令牌机制进行资源请求校验;

- Admin HTTP API目前不支持API令牌。API令牌目前仅链接到组织和组织角色。他们无法获得服务器管理员的许可,只有用户才能获得该权限。因此,为了使用这些API调用,您必须使用Basic Auth,Grafana用户必须具有Grafana Admin权限。(默认管理员用户被调用admin并且有权使用此API。)

官方文档地址:https://grafana.com/docs/http_api/admin/

6.2 关于用户登录验证请求资源

- 无法使用HTTP API的部分,可以使用RestTemplate等工具模拟登录验证,获取Cookie请求资源;而请求资源我们可以使用F12 获取请求的接口地址,需要哪些资源,直接到相关站点界面获取接口地址,模拟登录即可做对应的操作;

这部分不多加介绍,下面介绍使用HTTP API的方式;

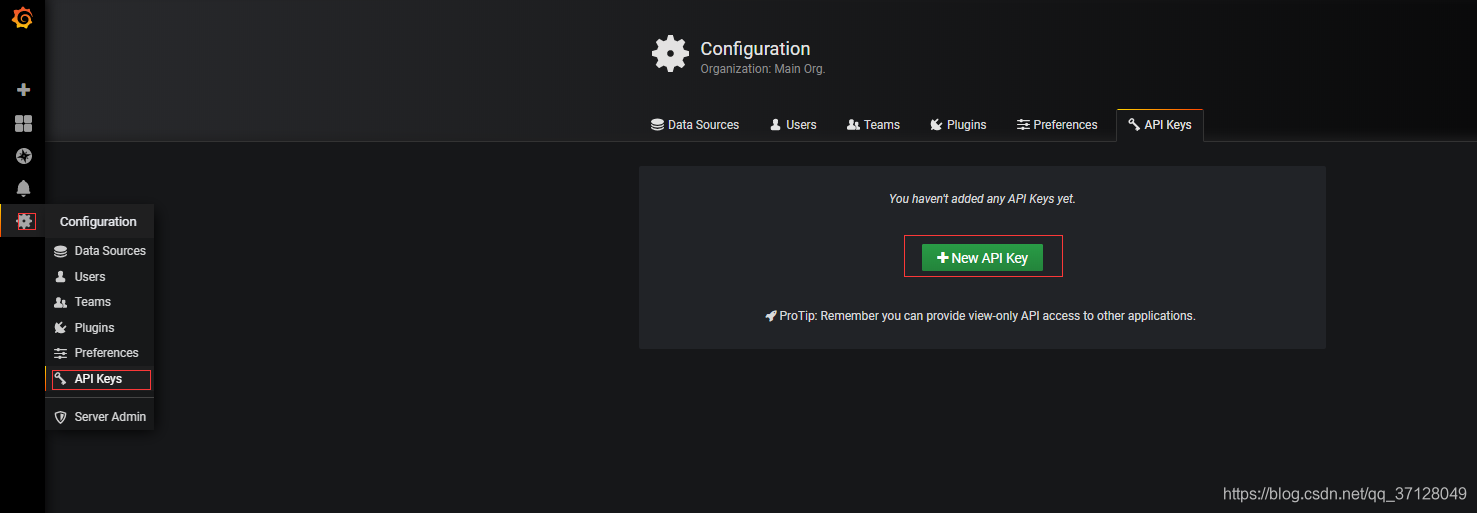

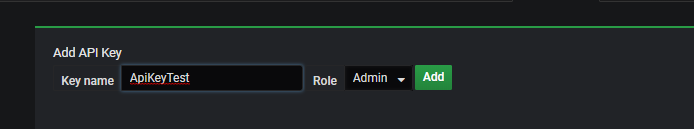

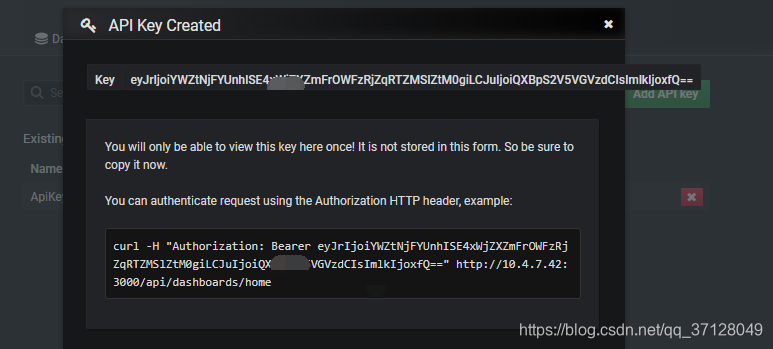

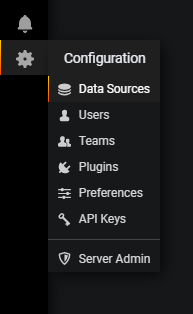

6.3 创建API 令牌

- 创建API KEY

- 点击保存

- 将Key后面的内容作为 Authorization中的Bearer 后的内容:

里面的权限为Viewer,Eidtor,和Admin,权限为只能看,可以部分写,以及全部权限;

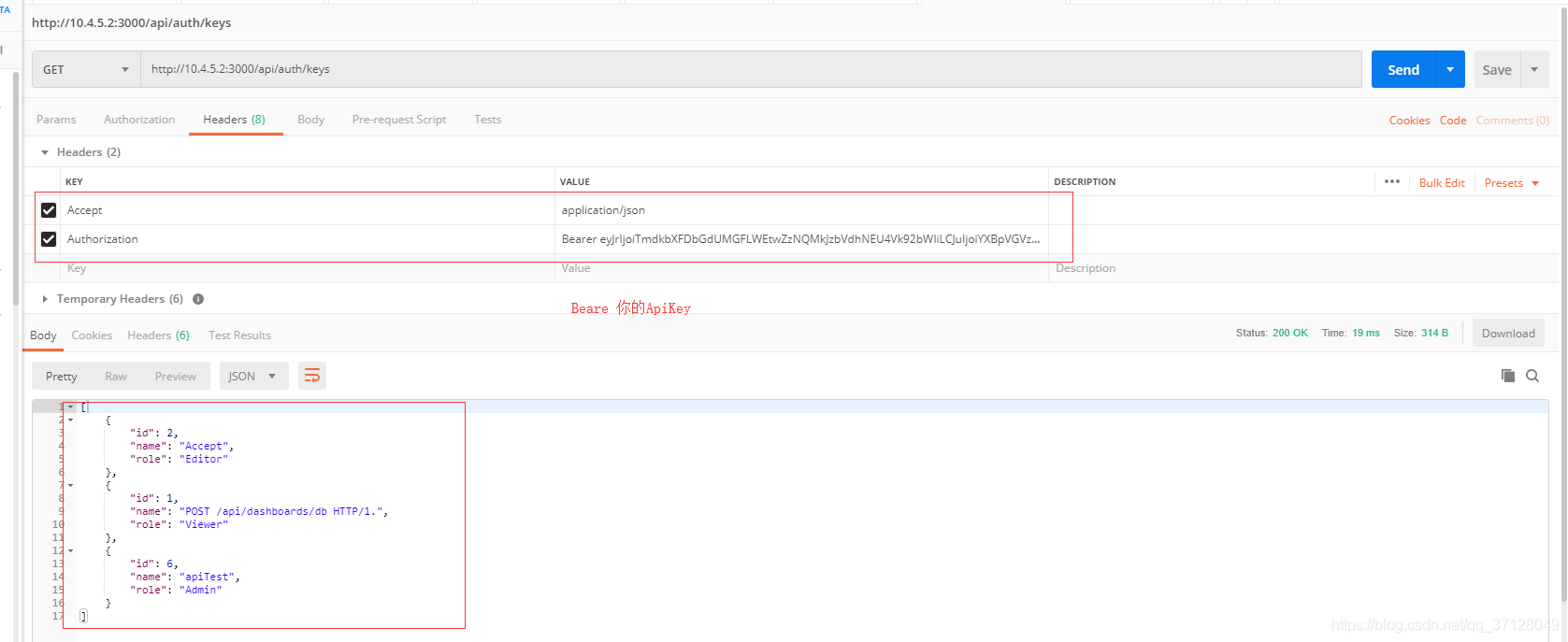

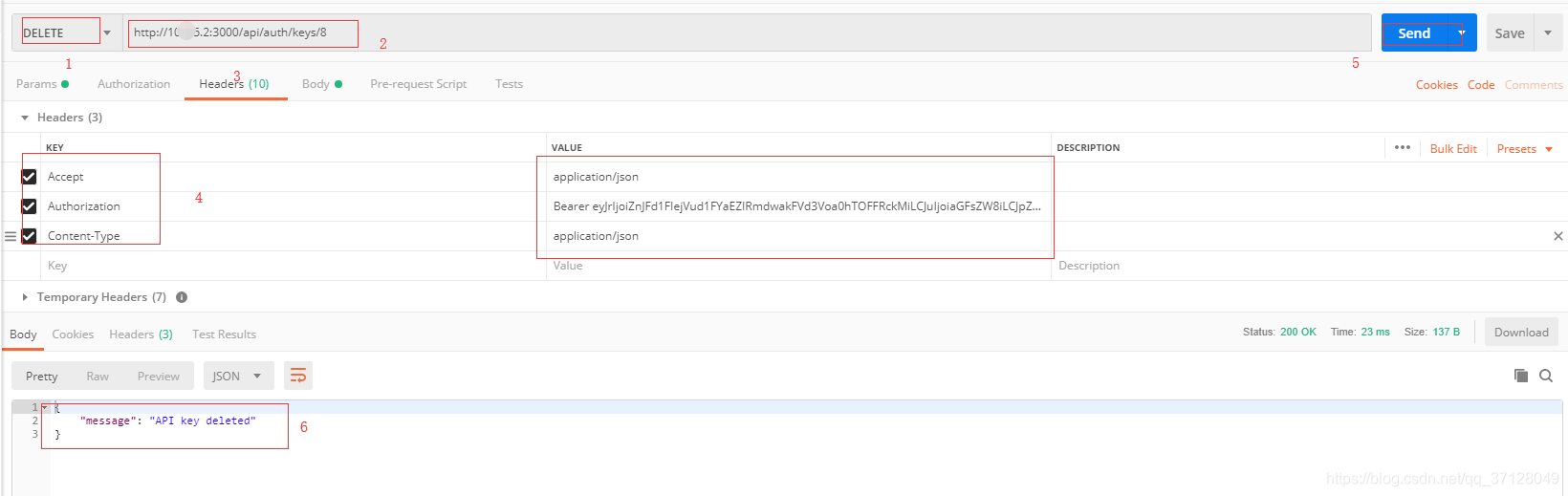

6.4 验证HTTP资源/操作 接口示例:

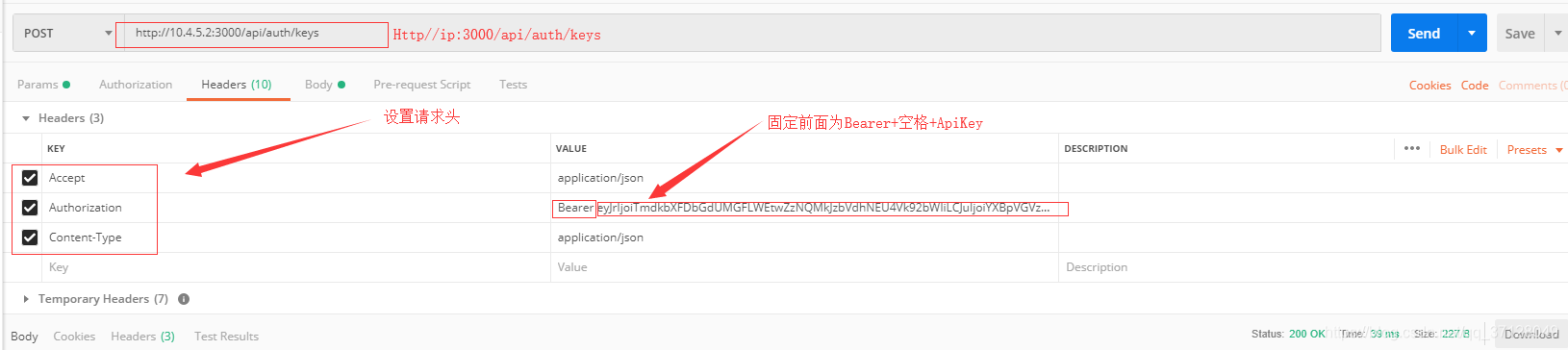

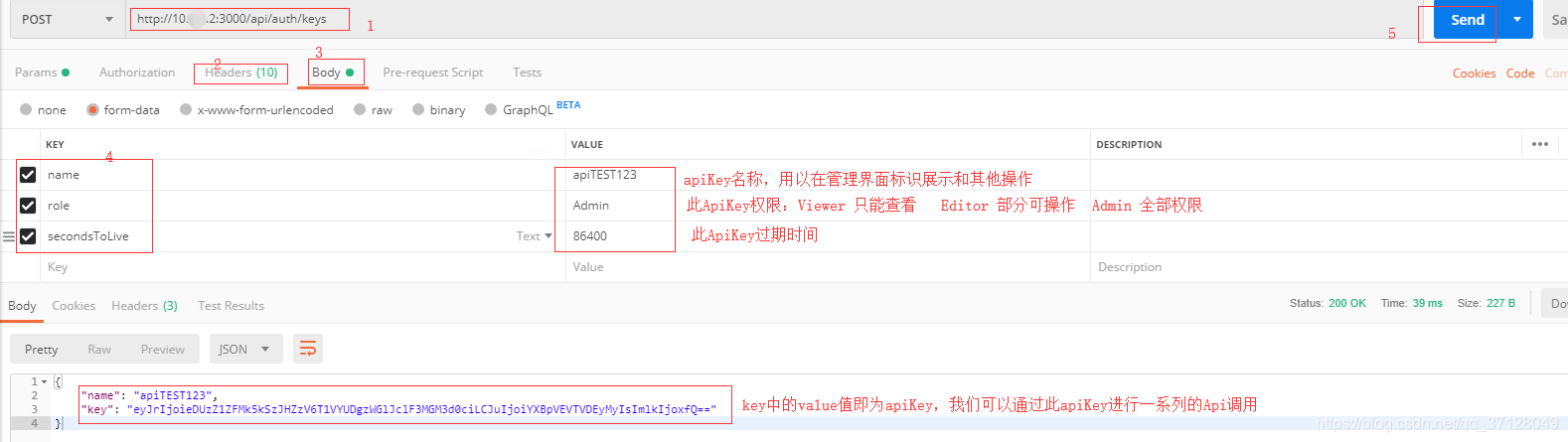

6.5 创建API Key 示例:

- 请求ip地址和请求头填写内容:

- 请求体内填写内容:

权限类别可分为Viewer,Editor和Admin,Viewer只能查看,Editor可以一些界面进行操作,而Admin是拥有所有权限的角色;

secondsToLive - 以秒为单位设置密钥到期时间。这是可选的。如果是正数,则设置密钥的到期日期。如果它为null,为零或完全省略(除非api_key_max_seconds_to_live设置了配置选项),密钥将永不过期。

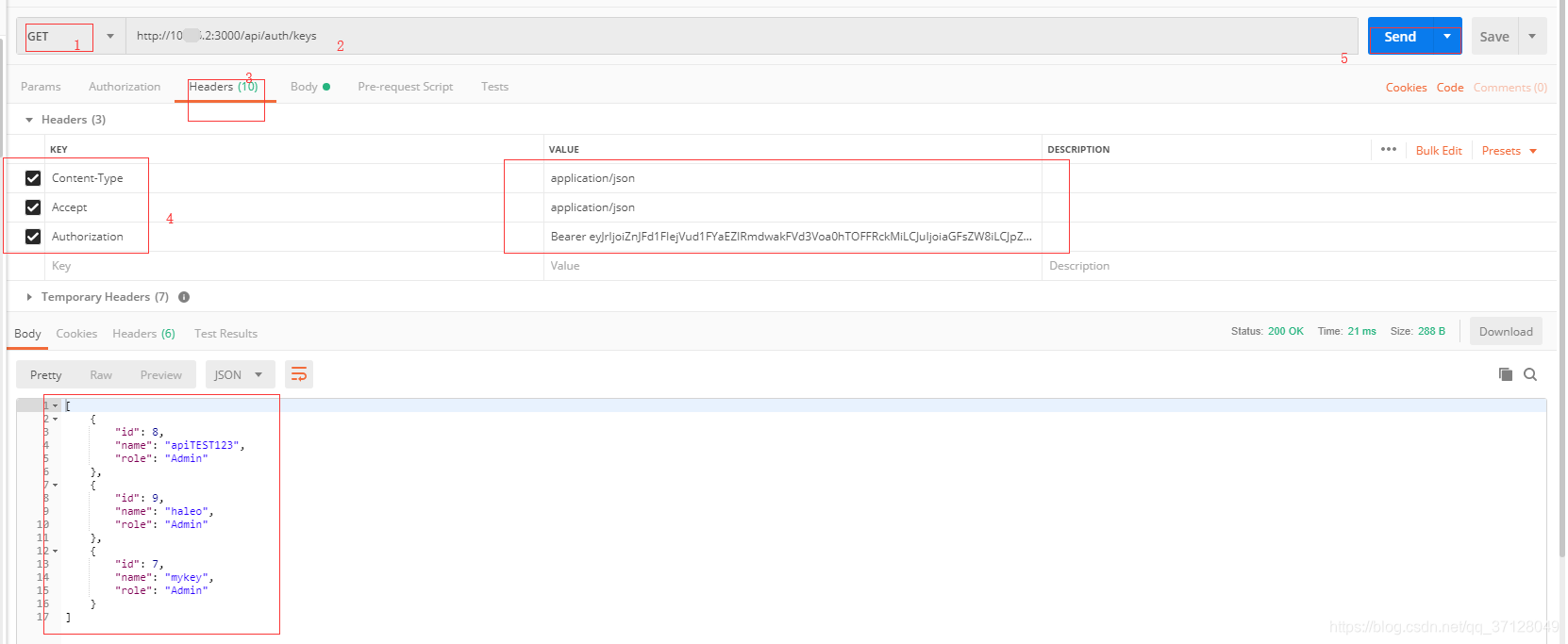

6.6 删除API Key示例:

- 先通过查询接口查询到所有Api Key列表

- 拿到需要删除的ApiKey的id,然后使用Delete请求方式,在最后带id即可删除对应id的ApiKey,图示如下:

只要支持HTTP API的均可使用此方式,具体的请求路径和对应资源可进入官方文档查看;

https://grafana.com/docs/http_api/dashboard/

七. Grafana监控系统之监控RabbitMQ

7.1 下载并解压

- 下载:

wget https://github.com/kbudde/rabbitmq_exporter/releases/download/v1.0.0-RC5/rabbitmq_exporter-1.0.0-RC5.linux-amd64.tar.gz

没有wget等命令请自行搜索下载

-

解压:

tar -xvf rabbitmq_exporter-1.0.0-RC5.linux-amd64.tar.gz -

进入目录:

cd rabbitmq_exporter-1.0.0-RC5.linux-amd64 -

执行命令:

RABBIT_USER=guest RABBIT_PASSWORD=guest OUTPUT_FORMAT=JSON PUBLISH_PORT=9099 RABBIT_URL=http://localhost:15672 nohup ./rabbitmq_exporter 2>&1 &

注意里面的PABBIT_USER的账号,以及后面的密码,请按实际账号密码输入,以及端口等;

7.2 加入Prometheus.yml

-

进入有Prometheus的服务器,进入Prometheus,编辑prometheus.yml

vim prometheus.yml -

配置如下内容:

- job_name: 'RabbitMQ' static_configs: - targets: ['Rabbit的ip地址:9099']

这里的ip地址写Rabbit的地址,端口号默认都写9099;

7.3 进入Grafana配置RabbitMQ地址

- 浏览器输入:ip地址+3000 进入Grafana 默认账户和密码都是admin

- 点击小齿轮,点击**Data Sources **

- 点击右侧 **Add data source ** 选择Prometheus

- 编辑Prometheus的配置信息,Name为名称,URL为 http://promethues的服务器地址和端口号(9090)

这里的URL不是写RabbitMQ的服务器地址,而是Prometheus的地址,注意不要弄错;

- 点击Save&Test进行测试,如果下方出现小绿条提示: Data source is working 则说明安装成功

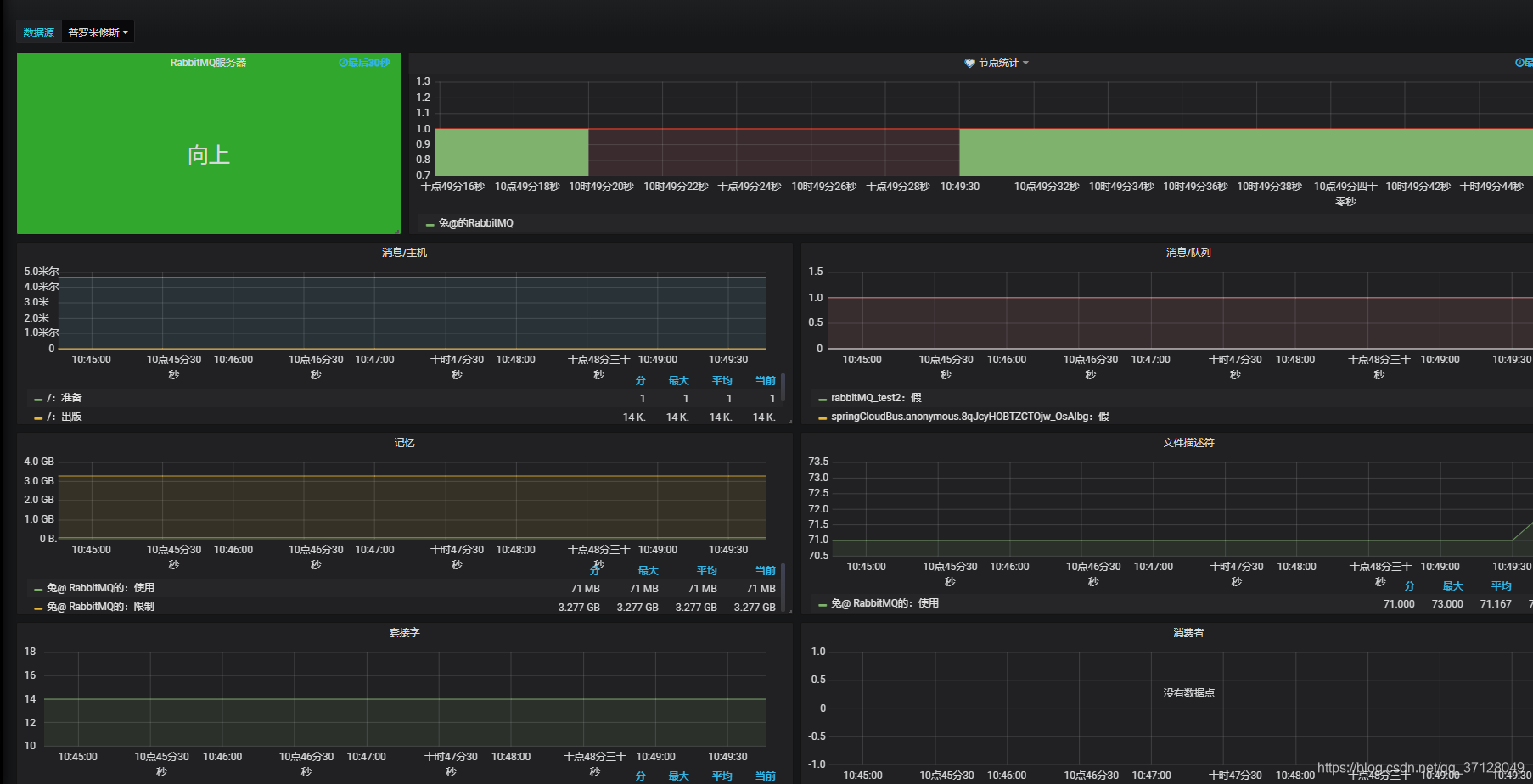

- 点击左侧的 + 图标,选择Import,在第一个输入框中输入 2121 ,然后点击 Load

- 点击左侧小方块图标,点击Manage 选择刚刚配好的,点击进入即可展示,效果图如下:

八. Grafana监控系统之监控Redis

8.1 下载并解压

- 下载:

wget https://github.com/oliver006/redis_exporter/releases/download/v1.0.3/redis_exporter-v1.0.3.linux-amd64.tar.gz - 解压:

tar -xvf redis_exporter-v1.0.3.linux-amd64.tar.gz

8.2 启动 Redis_exporter

- 无密码:

./redis_exporter redis//192.168.1.120:6379 & - 有密码:

redis_exporter -redis.addr 192.168.1.120:6379 -redis.password 123456****

里面的ip地址和端口号请根据自身实际来

8.3 配置Prometheus.yml

- 进入prometheus的服务器,然后进入prometheus.yml,进行编辑:

- 编辑:

vim prometheus.yml - 内容如下:

- job_name: redis static_configs: - targets: ['ip地址:9121']

8.4 检查Redis状态

- 进入地址

Premetheus的ip地址:9090/targets

如果显示State的结果为 UP 则说明成功。

8.5 配置Grafana的数据源

- 登录网站:

Grafana的ip地址:3000 - 添加数据源,如果之前已经在Grafana中添加了此DataSource(指向了安装有Prometheus的ip地址和对应端口),则无需重新添加,在导入面板的时候,可以直接引用此DataSource;

8.6 配置展示面板

- 先进行登陆,登陆后点击 + 号选择Import

- 在第一个框框内输入: 731

注意,也可以自己找其他的展示面板,在官方的面板页面找到数据源为Prometheus的Redis展示面板,在上方所说的对应位置输入它的编号即可

官方控制面板地址:https://grafana.com/dashboards

8.7 直接查看,展示效果图如下:

九.Grafana监控系统之监控TiDB

9.1 下载二进制包并解压

- 下载

wget https://github.com/prometheus/node_exporter/releases/download/v0.15.2/node_exporter-0.15.2.linux-amd64.tar. - 解压

tar -xzf node_exporter-0.15.2.linux-amd64.tar.gz

9.2 启动服务

- 进入目录:

cd node_exporter-0.15.2.linux-amd64 - 启动 node_exproter服务

./node_exporter --web.listen-address=":9100" \ --log.level="info" &

9.3 在Prometheus.yml中配置

- 进入Prometheus所在的服务器,并进入该Prometheus目录

cd prometheus-2.2.1.linux-amd64 - 编辑 prometheus.yml

vim prometheus.yml - 新增内容如下:

- job_name: 'tidb' honor_labels: true # 不要覆盖 job 和实例的 label static_configs: - targets: ['tidb所在服务器ip地址:10080']

这里配置好了以后,需要重新启动一下Prometheus.yml,然后登陆 ip地址:9090/targets 如果Status显示为 UP 则说明成功;

9.4 启动Grafana服务

./prometheus \

--config.file="./prometheus.yml" \

--web.listen-address=":9090" \

--web.external-url="http://192.168.199.113:9090/" \

--web.enable-admin-api \

--log.level="info" \

--storage.tsdb.path="./data.metrics" \

--storage.tsdb.retention="15d" &

9.5 启动Grafana并配置DataSource

- 按照正常命令启动,如果已经启动过则无需改;

- 如果前面已经对此Prometheus的DataSource进行过配置,则无需再次配置,在导入展示面板的时候直接指向此已经写好的展示面板即可;

9.6 导入Grafana面板

-

在侧边栏菜单中,依次点击 + 号 > Import 打开 Import Dashboard 窗口。

-

点击 Upload .json File 上传对应的 JSON 文件(https://github.com/pingcap/tidb-ansible/tree/master/scripts)。

-

注意:TiDB 面板对应的 JSON 文件为tidb.json 。 (我们可以通过上面的链接进入找到此tidb.json然后将内容复制出来命名为tidb.json然后导入)

-

点击 Load。

-

选择一个 Prometheus 数据源。(以前对这个Prometheus创建过数据源,我们可以重复利用,直接指向即可)

-

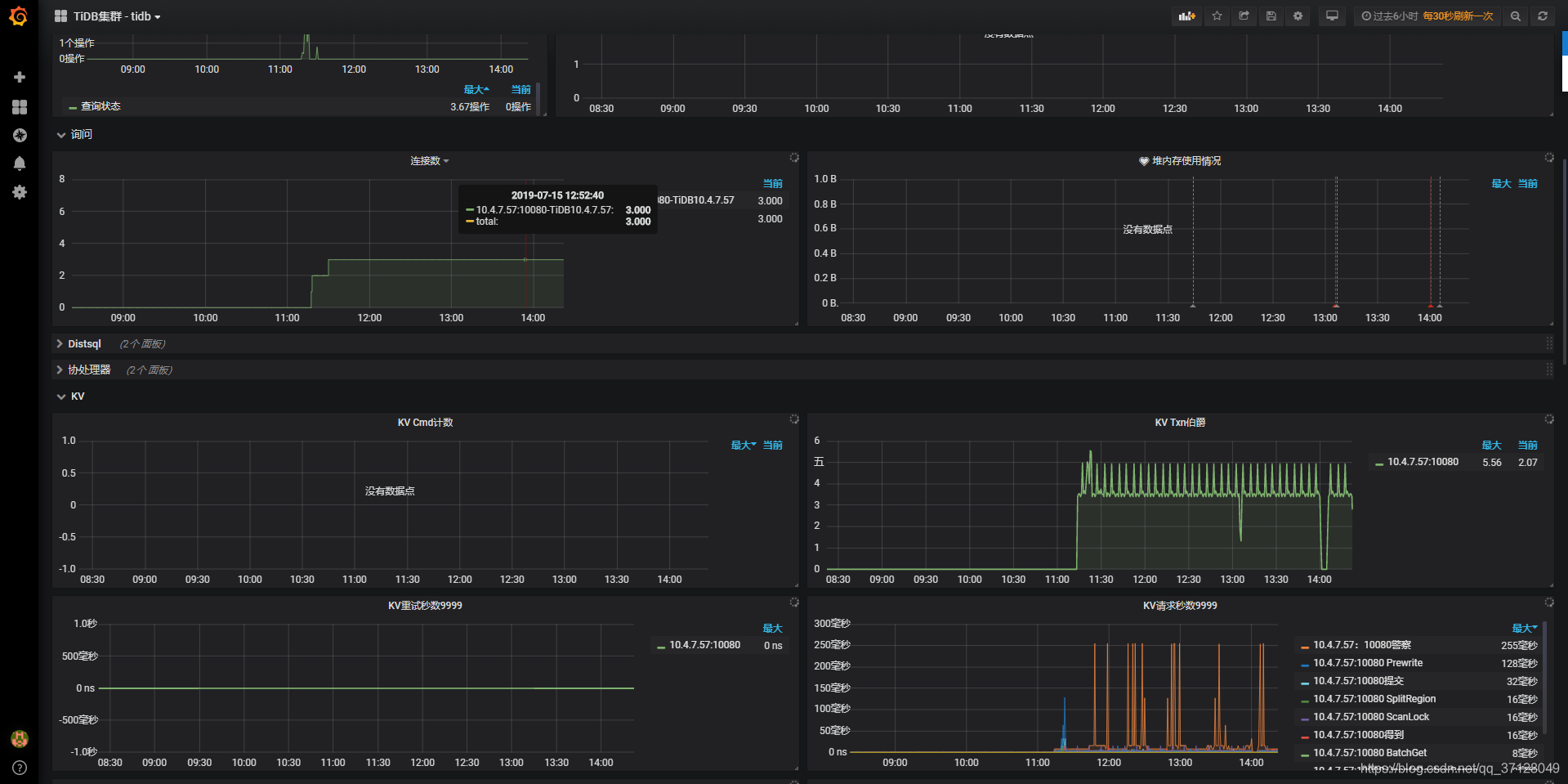

点击 Import,Prometheus 面板即导入成功。

9.7 在Mangae 里面可以直接预览,展示效果图如下

码子不易,喜欢的话点个关注或收藏吧~ ^^

智能推荐

从零开始搭建Hadoop_创建一个hadoop项目-程序员宅基地

文章浏览阅读331次。第一部分:准备工作1 安装虚拟机2 安装centos73 安装JDK以上三步是准备工作,至此已经完成一台已安装JDK的主机第二部分:准备3台虚拟机以下所有工作最好都在root权限下操作1 克隆上面已经有一台虚拟机了,现在对master进行克隆,克隆出另外2台子机;1.1 进行克隆21.2 下一步1.3 下一步1.4 下一步1.5 根据子机需要,命名和安装路径1.6 ..._创建一个hadoop项目

心脏滴血漏洞HeartBleed CVE-2014-0160深入代码层面的分析_heartbleed代码分析-程序员宅基地

文章浏览阅读1.7k次。心脏滴血漏洞HeartBleed CVE-2014-0160 是由heartbeat功能引入的,本文从深入码层面的分析该漏洞产生的原因_heartbleed代码分析

java读取ofd文档内容_ofd电子文档内容分析工具(分析文档、签章和证书)-程序员宅基地

文章浏览阅读1.4k次。前言ofd是国家文档标准,其对标的文档格式是pdf。ofd文档是容器格式文件,ofd其实就是压缩包。将ofd文件后缀改为.zip,解压后可看到文件包含的内容。ofd文件分析工具下载:点我下载。ofd文件解压后,可以看到如下内容: 对于xml文件,可以用文本工具查看。但是对于印章文件(Seal.esl)、签名文件(SignedValue.dat)就无法查看其内容了。本人开发一款ofd内容查看器,..._signedvalue.dat

基于FPGA的数据采集系统(一)_基于fpga的信息采集-程序员宅基地

文章浏览阅读1.8w次,点赞29次,收藏313次。整体系统设计本设计主要是对ADC和DAC的使用,主要实现功能流程为:首先通过串口向FPGA发送控制信号,控制DAC芯片tlv5618进行DA装换,转换的数据存在ROM中,转换开始时读取ROM中数据进行读取转换。其次用按键控制adc128s052进行模数转换100次,模数转换数据存储到FIFO中,再从FIFO中读取数据通过串口输出显示在pc上。其整体系统框图如下:图1:FPGA数据采集系统框图从图中可以看出,该系统主要包括9个模块:串口接收模块、按键消抖模块、按键控制模块、ROM模块、D.._基于fpga的信息采集

微服务 spring cloud zuul com.netflix.zuul.exception.ZuulException GENERAL-程序员宅基地

文章浏览阅读2.5w次。1.背景错误信息:-- [http-nio-9904-exec-5] o.s.c.n.z.filters.post.SendErrorFilter : Error during filteringcom.netflix.zuul.exception.ZuulException: Forwarding error at org.springframework.cloud..._com.netflix.zuul.exception.zuulexception

邻接矩阵-建立图-程序员宅基地

文章浏览阅读358次。1.介绍图的相关概念 图是由顶点的有穷非空集和一个描述顶点之间关系-边(或者弧)的集合组成。通常,图中的数据元素被称为顶点,顶点间的关系用边表示,图通常用字母G表示,图的顶点通常用字母V表示,所以图可以定义为: G=(V,E)其中,V(G)是图中顶点的有穷非空集合,E(G)是V(G)中顶点的边的有穷集合1.1 无向图:图中任意两个顶点构成的边是没有方向的1.2 有向图:图中..._给定一个邻接矩阵未必能够造出一个图

随便推点

MDT2012部署系列之11 WDS安装与配置-程序员宅基地

文章浏览阅读321次。(十二)、WDS服务器安装通过前面的测试我们会发现,每次安装的时候需要加域光盘映像,这是一个比较麻烦的事情,试想一个上万个的公司,你天天带着一个光盘与光驱去给别人装系统,这将是一个多么痛苦的事情啊,有什么方法可以解决这个问题了?答案是肯定的,下面我们就来简单说一下。WDS服务器,它是Windows自带的一个免费的基于系统本身角色的一个功能,它主要提供一种简单、安全的通过网络快速、远程将Window..._doc server2012上通过wds+mdt无人值守部署win11系统.doc

python--xlrd/xlwt/xlutils_xlutils模块可以读xlsx吗-程序员宅基地

文章浏览阅读219次。python–xlrd/xlwt/xlutilsxlrd只能读取,不能改,支持 xlsx和xls 格式xlwt只能改,不能读xlwt只能保存为.xls格式xlutils能将xlrd.Book转为xlwt.Workbook,从而得以在现有xls的基础上修改数据,并创建一个新的xls,实现修改xlrd打开文件import xlrdexcel=xlrd.open_workbook('E:/test.xlsx') 返回值为xlrd.book.Book对象,不能修改获取sheett_xlutils模块可以读xlsx吗

关于新版本selenium定位元素报错:‘WebDriver‘ object has no attribute ‘find_element_by_id‘等问题_unresolved attribute reference 'find_element_by_id-程序员宅基地

文章浏览阅读8.2w次,点赞267次,收藏656次。运行Selenium出现'WebDriver' object has no attribute 'find_element_by_id'或AttributeError: 'WebDriver' object has no attribute 'find_element_by_xpath'等定位元素代码错误,是因为selenium更新到了新的版本,以前的一些语法经过改动。..............._unresolved attribute reference 'find_element_by_id' for class 'webdriver

DOM对象转换成jQuery对象转换与子页面获取父页面DOM对象-程序员宅基地

文章浏览阅读198次。一:模态窗口//父页面JSwindow.showModalDialog(ifrmehref, window, 'dialogWidth:550px;dialogHeight:150px;help:no;resizable:no;status:no');//子页面获取父页面DOM对象//window.showModalDialog的DOM对象var v=parentWin..._jquery获取父window下的dom对象

什么是算法?-程序员宅基地

文章浏览阅读1.7w次,点赞15次,收藏129次。算法(algorithm)是解决一系列问题的清晰指令,也就是,能对一定规范的输入,在有限的时间内获得所要求的输出。 简单来说,算法就是解决一个问题的具体方法和步骤。算法是程序的灵 魂。二、算法的特征1.可行性 算法中执行的任何计算步骤都可以分解为基本可执行的操作步,即每个计算步都可以在有限时间里完成(也称之为有效性) 算法的每一步都要有确切的意义,不能有二义性。例如“增加x的值”,并没有说增加多少,计算机就无法执行明确的运算。 _算法

【网络安全】网络安全的标准和规范_网络安全标准规范-程序员宅基地

文章浏览阅读1.5k次,点赞18次,收藏26次。网络安全的标准和规范是网络安全领域的重要组成部分。它们为网络安全提供了技术依据,规定了网络安全的技术要求和操作方式,帮助我们构建安全的网络环境。下面,我们将详细介绍一些主要的网络安全标准和规范,以及它们在实际操作中的应用。_网络安全标准规范